光学基礎

1. 衛星の特徴

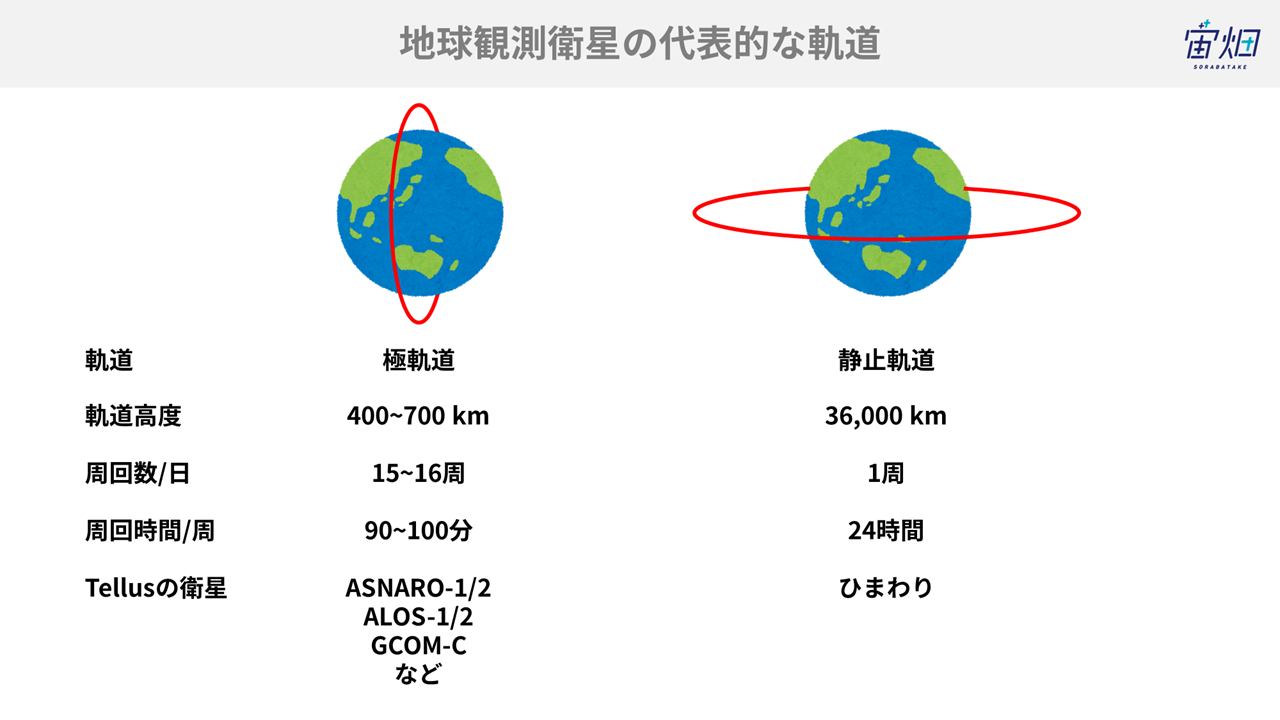

地球観測衛星が周回する代表的な軌道*1は、極軌道と静止軌道です。極軌道は北極と南極付近を、静止軌道は赤道上をそれぞれ周回しています。

極軌道の場合は90~100分ほどで地球を周回している衛星が多く、常時同じ場所を観測できるわけではありません。衛星にも依りますが、極軌道を取る衛星の場合は、地球を一日に15~16周回します。ただし、これは同じ場所を15~16回観測できることを意味しているわけではありません。一機の衛星では、同じ場所を1週間から1か月に1度程度しか観測できません。観測する頻度のことを、回帰日数、という言い方で表します。近年は、コンステレーションという、同一型の衛星を複数機打ち上げる方法で、観測頻度を上げる試みも行われ、同一地点を毎日観測できるようにもなり始めています。

対照的に、静止軌道の衛星は常時同一地点を観測できます。そのため、静止軌道を取る代表的な衛星である気象衛星ひまわりは、24時間気象情報を私たちに届けることができます。

*1...衛星が通る道のこと。基本的に人工衛星は同じ道を周回し続けます。ただし、地球が自転しているため、観測する場所は周回ごとに異なります。詳しくはこちらの映像をご覧ください。

名古屋市科学館_宇宙から地球を解き明かす-地球観測衛星のまなざし-

https://www.youtube.com/watch?v=MJb-nCeGljI&feature=youtu.be

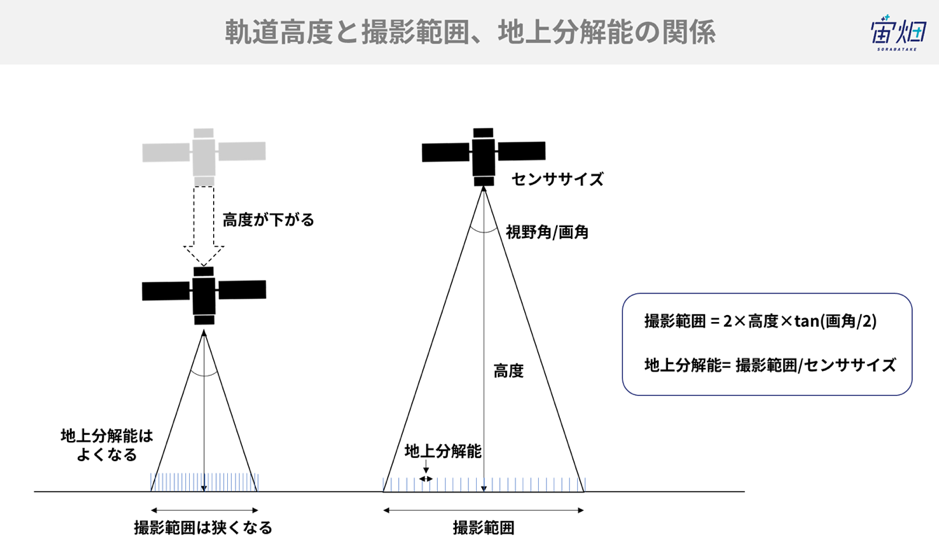

それであれば、常時観測可能な静止軌道にすべての衛星を投入すれば良いのでは、と思われる方もいらっしゃるかもしれません。軌道高度が高い、つまりは地上から衛星までの距離が遠くなると、広い視野を確保できるので、観測幅が広くなります。私たちで言うと、物を見るときに顔を遠ざけることで広い視野を確保できることと同じです。観測幅が広がると同一地点を観測する頻度が向上する利点があります。しかしながら、軌道高度が高くなると、観測する分解能は悪くなります。ノートから顔を離すと文字が読みにくくなるのと同じです。だからと言って高度を下げれば良いわけでもなく、高度が引きすぎると地球の大気の影響で軌道高度が徐々に下がるため、400 kmよりは上の高度が選択される場合が多いです。

たとえ観測分解能が悪くとも観測頻度を上げたい衛星もありますし、観測頻度を落としてでも観測分解能を上げたい衛星もあります。軌道高度(を含めた他の軌道要素*2)は観測したい対象により、適した値に決定されます。

*2...衛星の軌道は6つの要素を固定することで決定できます。これを軌道6要素と言います。代表的には軌道高度(軌道長半径と言います)や軌道傾斜角(赤道面と軌道面(衛星が周回する面)のなす角度)があります。

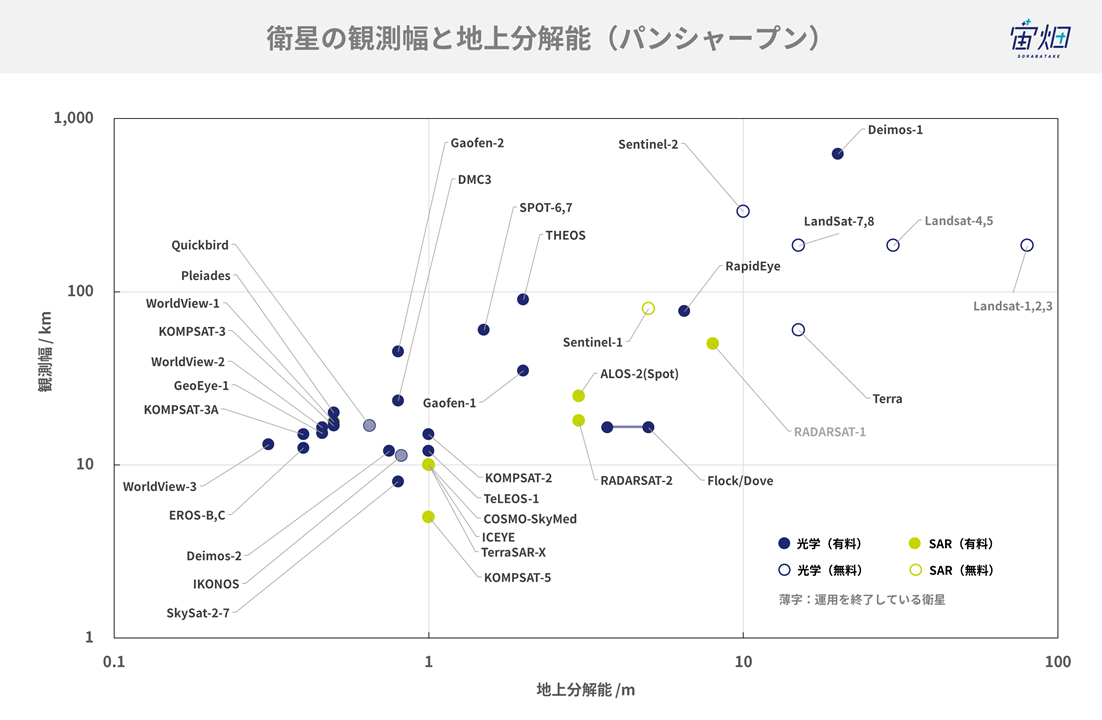

運用中の衛星の分解能と観測幅の関係をまとめると下図のようになります。分解能が良い衛星ほど、観測幅が狭くなっているのが分かります。

2. 観測するセンサ

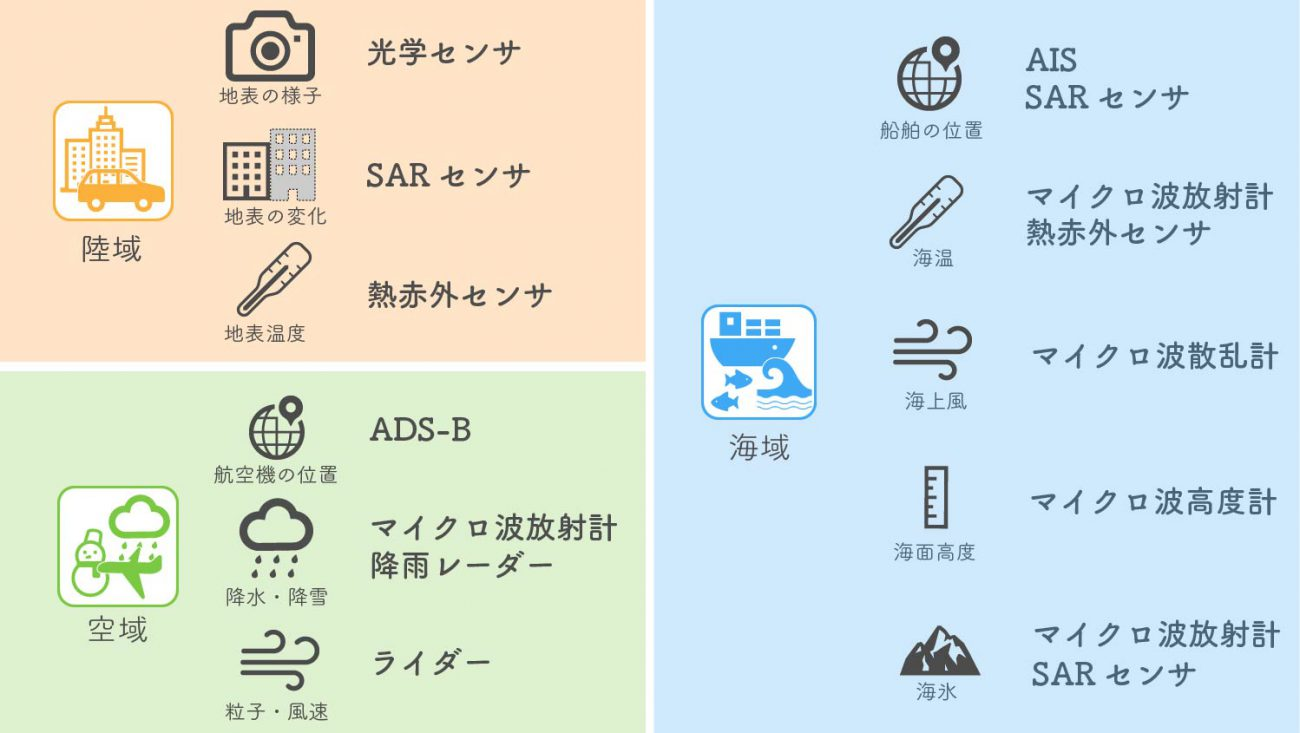

衛星は、陸域のみならず、海域や空域も観測しています。

大きくは、太陽光からの反射を観測する光学センサ、衛星が能動的に電波を放射してその反射を観測するSARセンサ、地上から生じる電磁波を観測している放射計に分けられます。

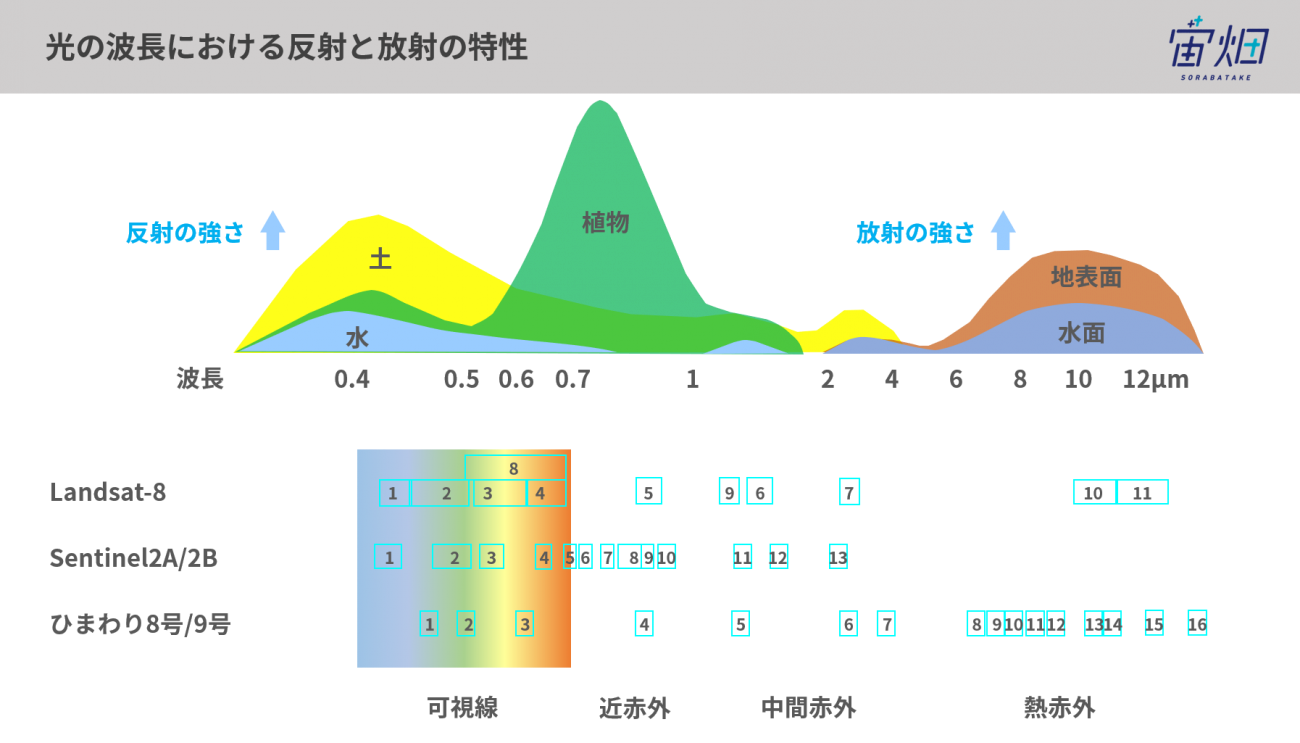

下図に示すように、物質はそれぞれ特徴を持った反射もしくは放射する特性を持っています。波長帯ごとに対象物を観測することで、対象物の状態を推測することが可能となります。

3. 衛星画像のパラメータ

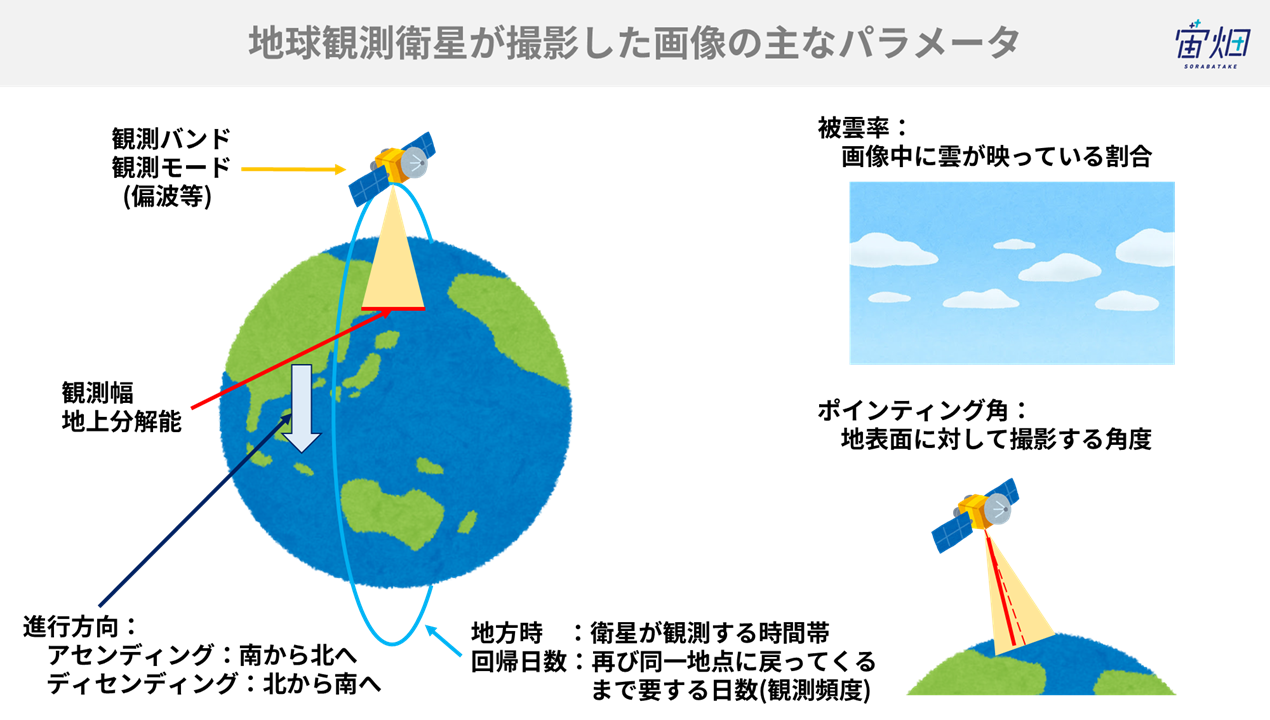

衛星画像の主たるパラメータには、下図のような項目があります。観測モードによって観測幅や地上分解能が変わったり、ポインティング角によって撮影された画像の見え方が異なったりします。

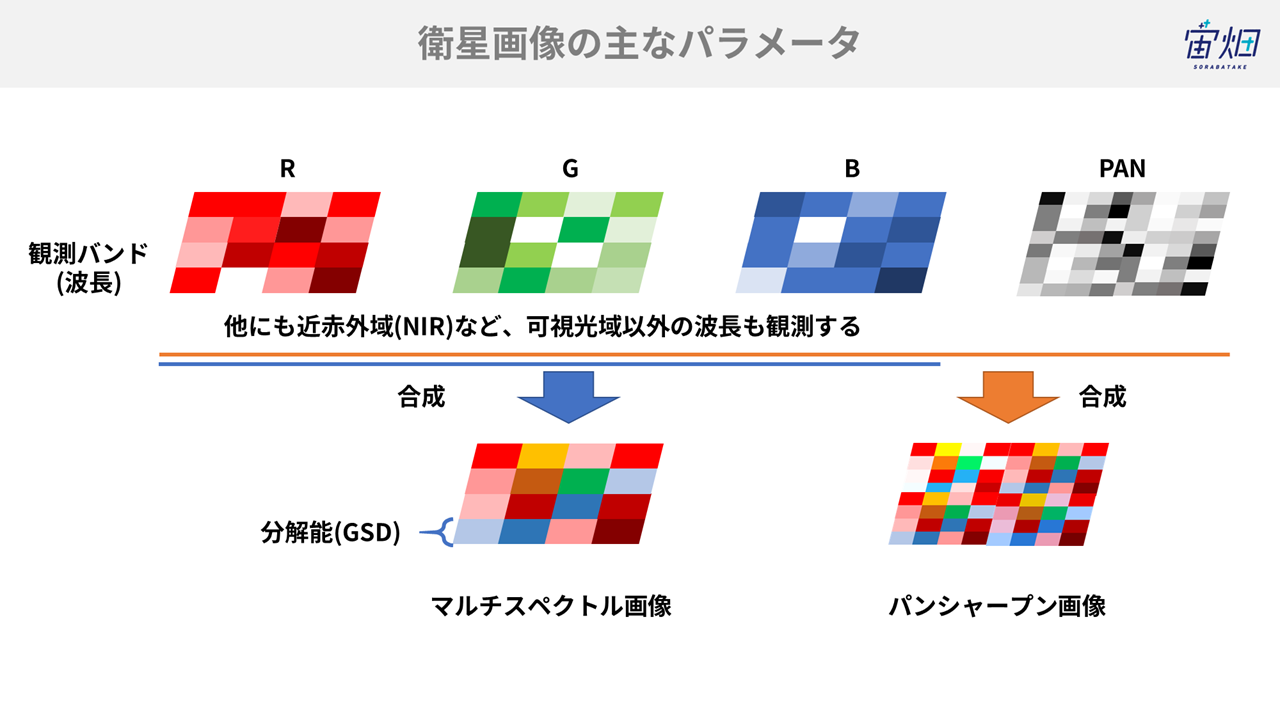

その中でも特に画像に関わるパラメータが下図になります。バンドは観測する周波数帯を表し、異なるバンドの撮像結果を組み合わせることで画像としています。大半の衛星は、パンクロマチック(パンクロやPANとも略称で呼ばれます)と呼ばれるグレースケールでの撮影と、マルチスペクトルと言われる可視光や赤外域などの波長帯での撮影をしています。パンクロで撮影した画像は、グレースケールである代わりに、マルチスペクトルで撮影した画像よりも高分解能になります。両画像の良い点を合わせ、分解能の良いカラー画像とする加工方法として、パンクロ画像とマルチスペクトルの画像を組み合わせたパンシャープン画像と呼ばれる合成がなされることもあります。

1ピクセルの画素が何 mに相当する物体を検出しているか、ということを表す指標が地上分解能(GSD:Ground sample distance)です。現在運用されている民間の衛星で最も良い分解能は0.3 mGSD相当になります。

4. 波長ごとの特徴

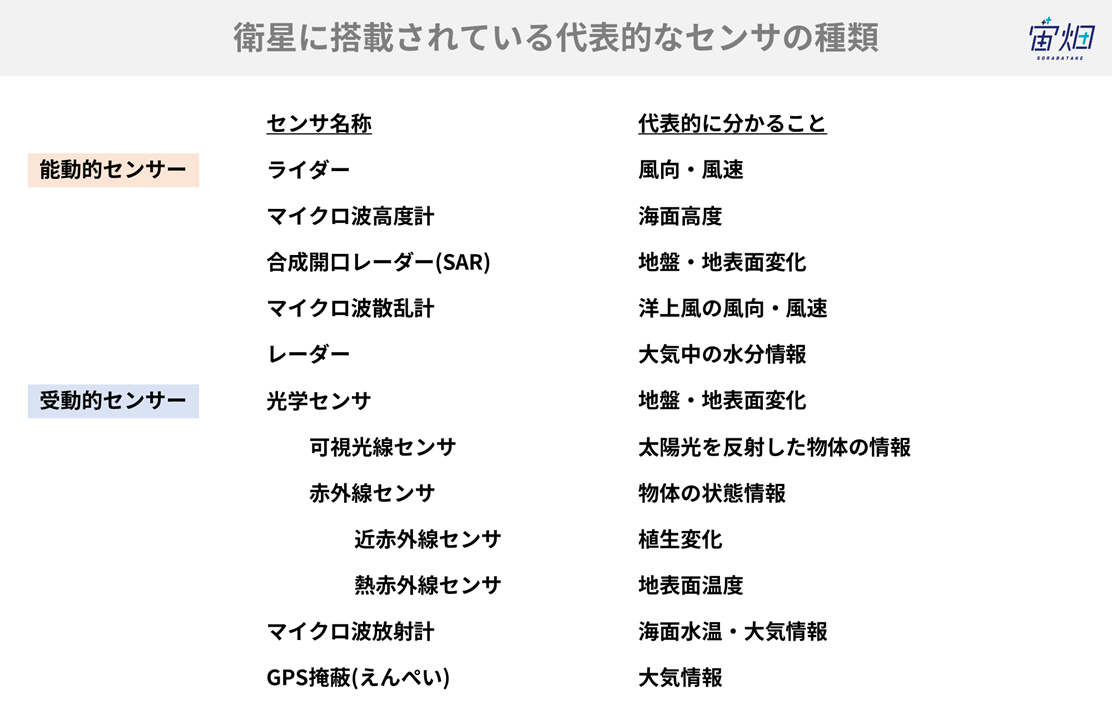

衛星は様々なセンサを搭載しており、観測手法は下図のように何通りもあります。

大きくは

- 衛星自体が能動的に電波等を発し、その反射を観測する能動的センサ

- 太陽光の反射や物体が発する電磁波を観測する受動的センサ

に大別できます。

それぞれの観測手法と利点/課題について見ていきましょう。

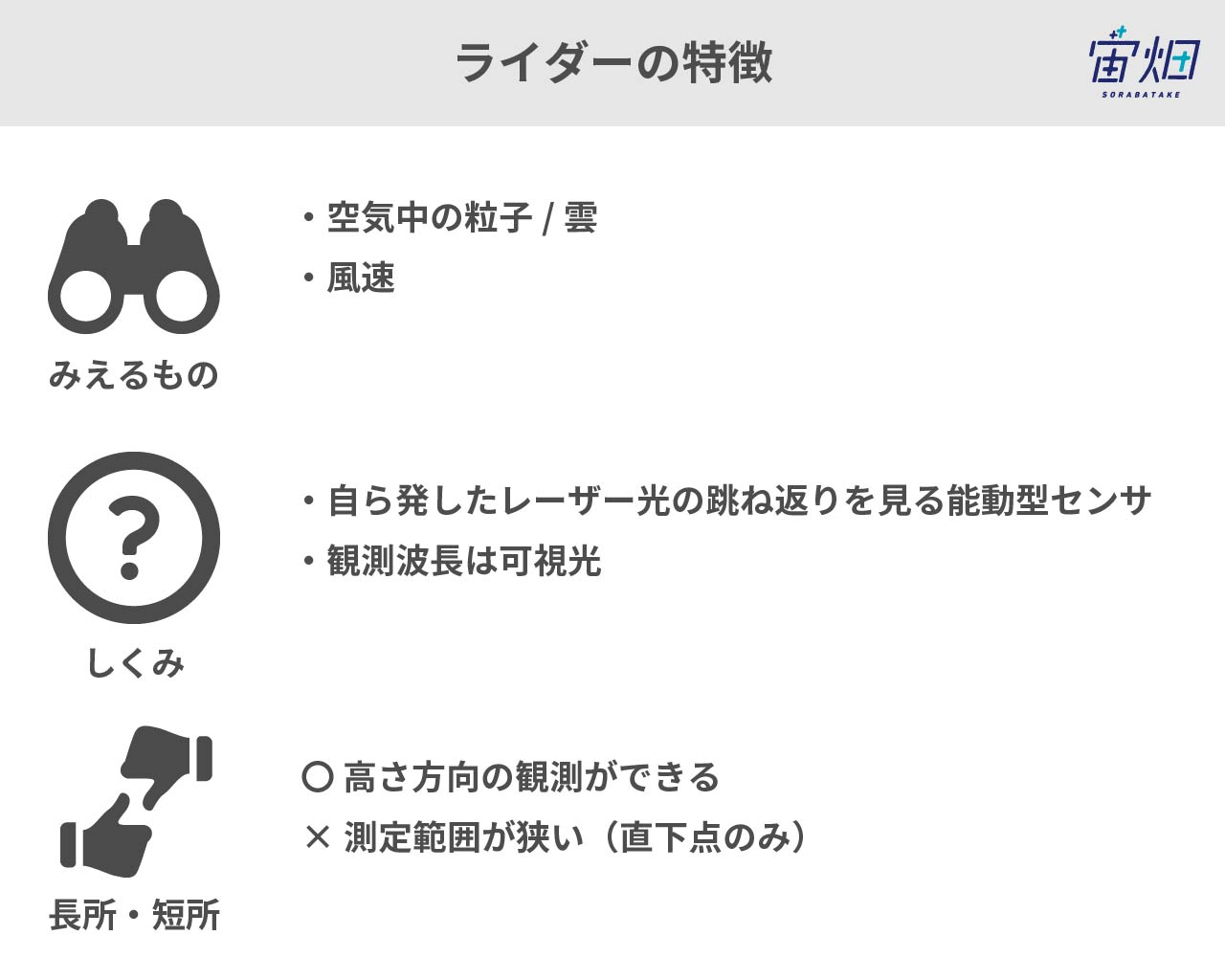

5. ライダー

ライダーは、マイクロ波ではなく主に紫外線領域の光を照射することで観測するセンサです*3。光の跳ね返りから、大気中の粒子の濃度を測定しています。ドップラー効果を利用することにより大気中の粒子の動き、すなわち風速を知ることもできます。

ライダーからは鉛直方向の情報も入手できるため、大気の構造の理解などに役立ちます。ただし、レーザー光のため一度に照射できる範囲が狭く観測範囲が狭いという特徴もあります。

*3…紫外線領域以外に、赤外線領域で観測するライダーもあります。

ISS 搭載植生ライダーミッション MOLI の概要と レーザ送信部試作試験状況

https://laser-sensing.jp/34thLSS/34th_papers/0187_G-1_murooka.pdf

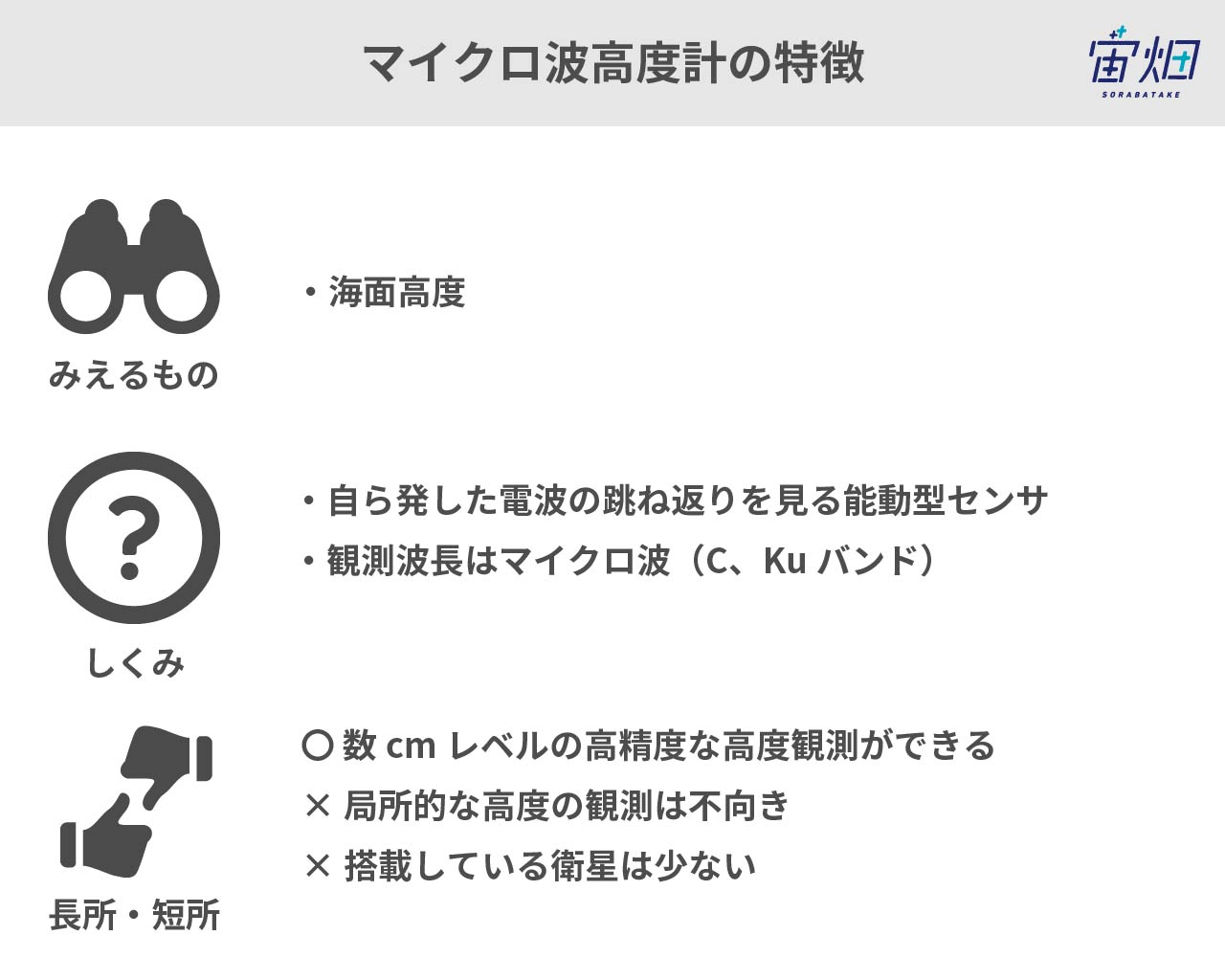

6. マイクロ波高度計

センサからマイクロ波を発射して反射して帰ってくるまでの時間から、高度を計算します。

高さ方向の精度は数cmと高精度ですが、マイクロ波が照射される範囲全体(直径数km)の平均高度となるため、陸域ではなく海面の高度計として用いられています。ただし、波のうねりを観測するわけではなく、潮の流れなどマクロな高度を観測しています。

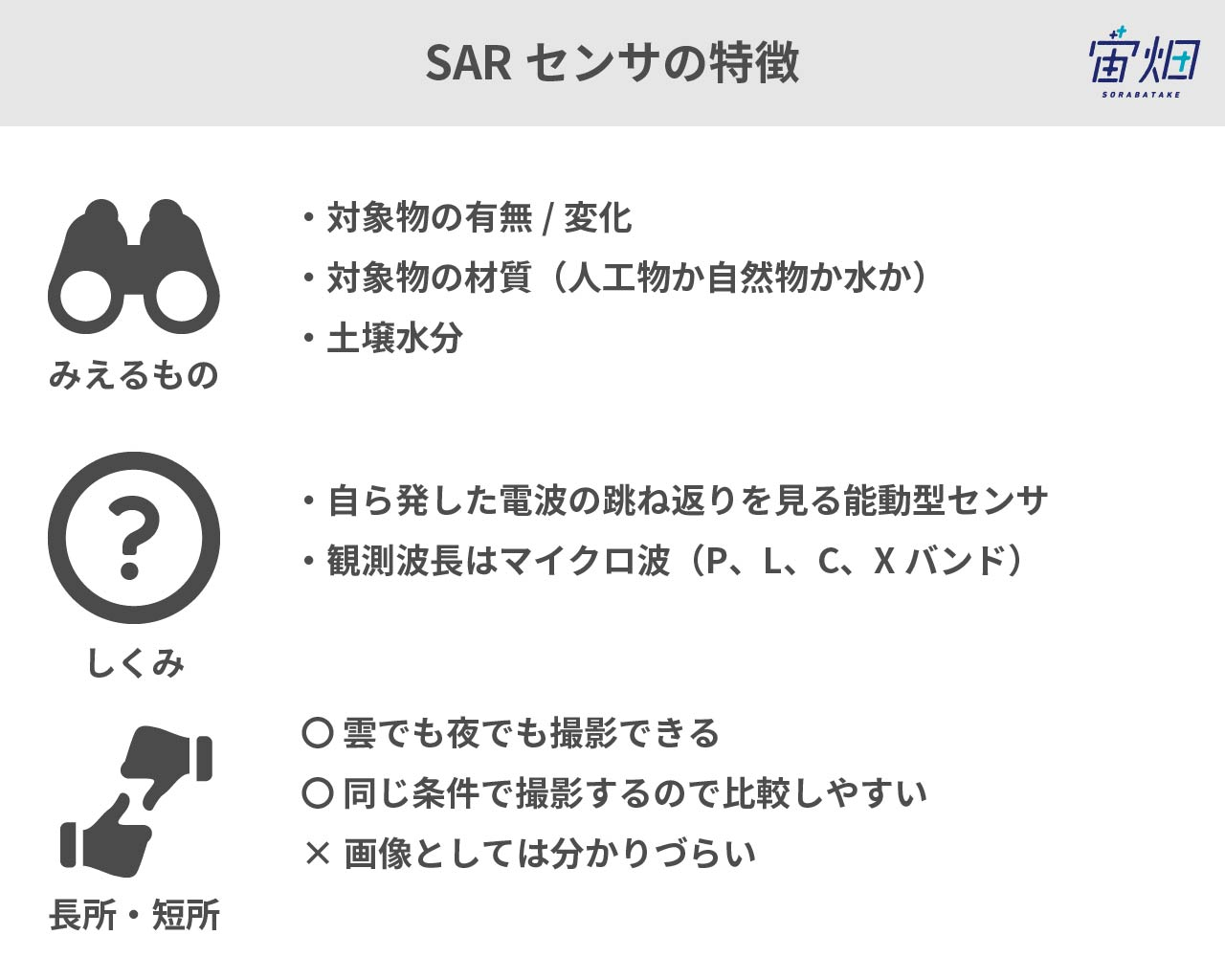

7. 合成開口レーダー

合成開口レーダー(SAR:Synthetic Aperture Radar)は、センサからマイクロ波を発射し、地表で跳ね返ってきたマイクロ波をとらえるセンサです。

ざらざらした表面ほど多く電波が返ってきて白くみえ、水面などつるつるした表面では電波が反射してしまうため黒く見えます。

詳しくはこちら:合成開口レーダ(SAR)のキホン~事例、分かること、センサ、衛星、波長~ https://sorabatake.jp/3364/

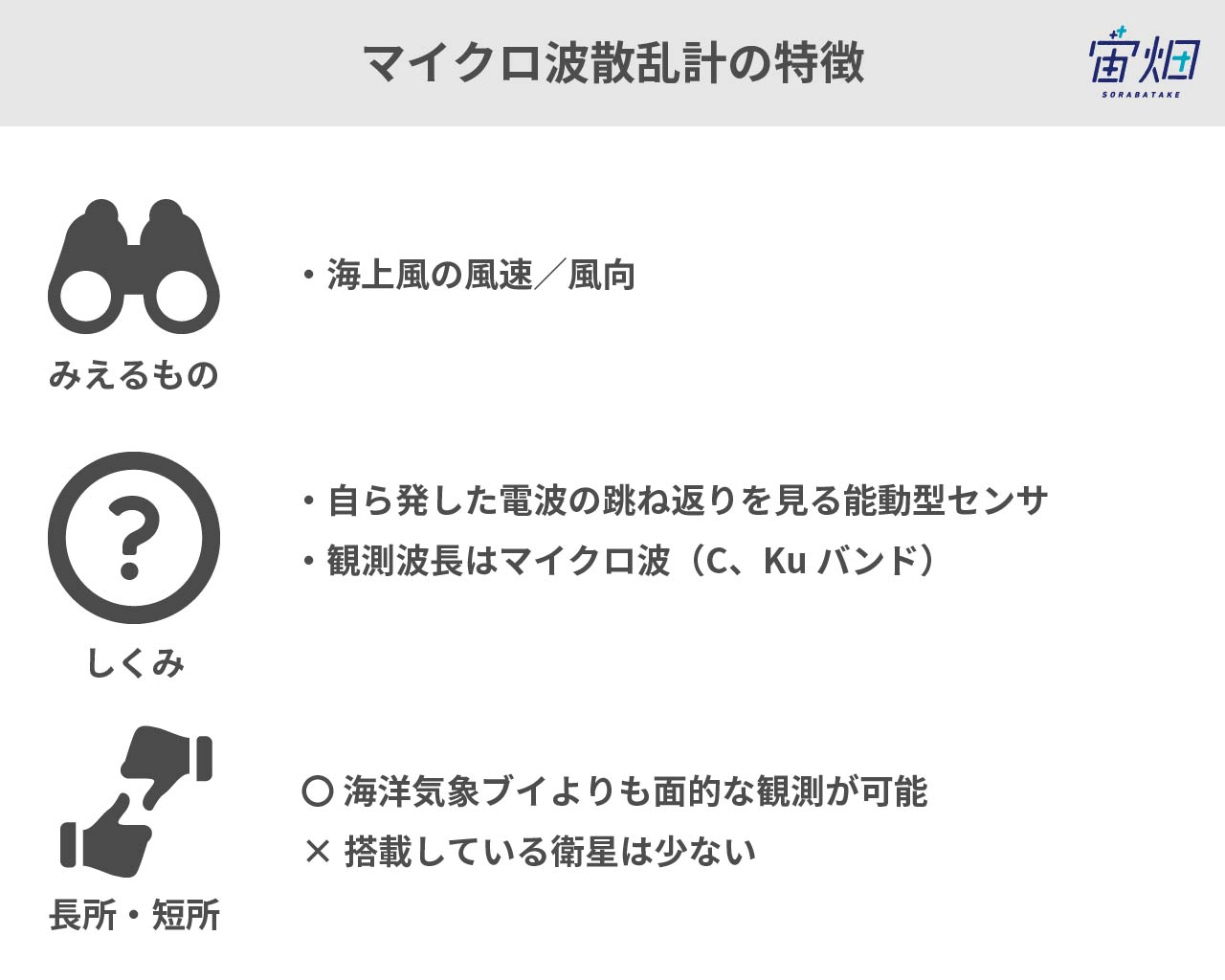

8. マイクロ波散乱計

海面に電波を照射すると、電波の波長に近い長さを持つ海面波の成分が散乱してレーダーに信号が受信されます。その信号の強さは、海上に吹いている風によって左右され、風向きとその強さに関係します。

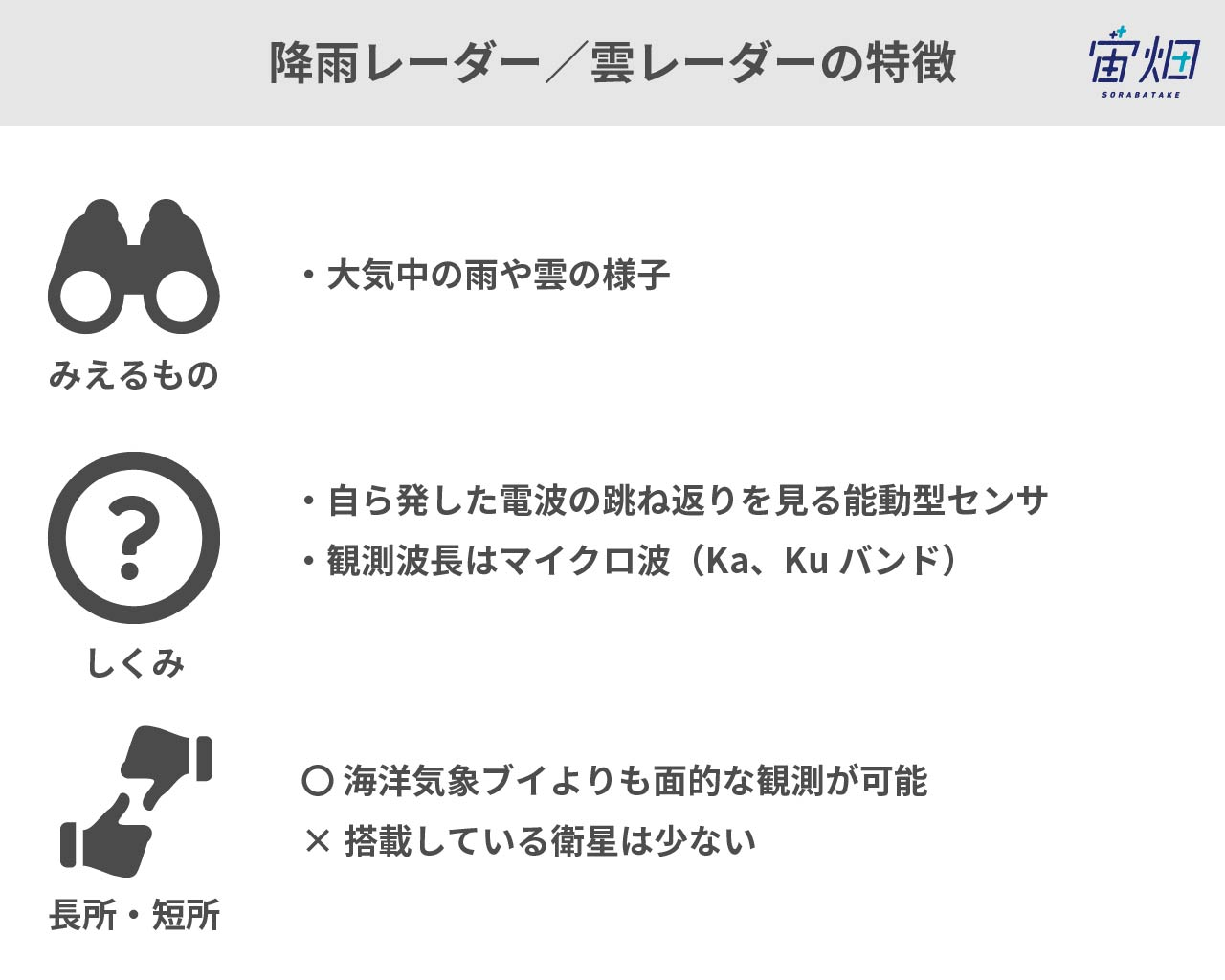

9. レーダー

大気中の雨や雲などの降水粒子に反射する波長のマイクロ波(Ka帯/Ku帯やミリ波等)を用いると、大気中の雨や雲の様子が計測できます。

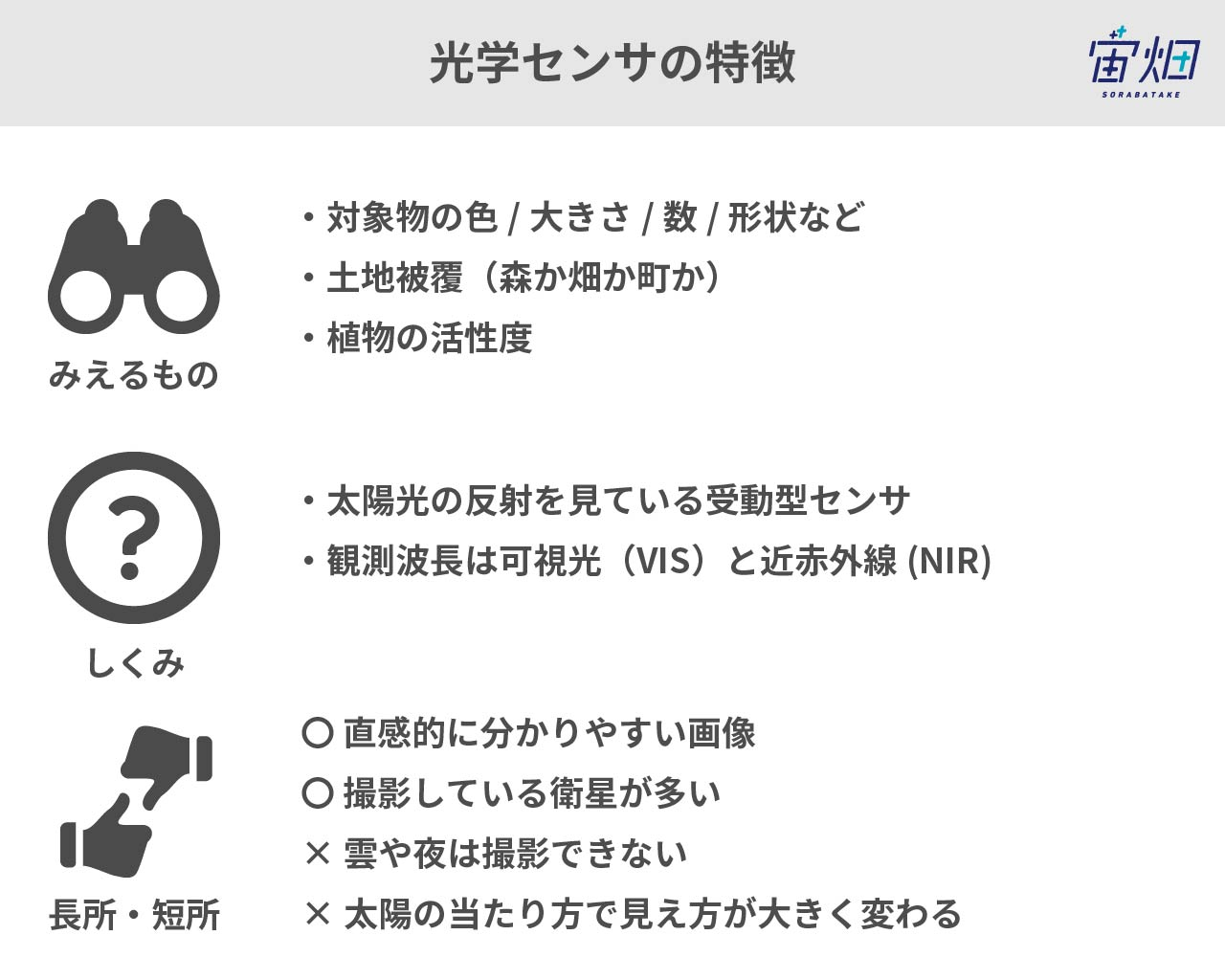

10. 光学センサ

衛星に搭載するセンサとしても最も一般的で、光学センサというとこのセンサを指すことが多いです。私たちが地上でよく使うカメラをイメージしていただくと良いと思います。

厳密には、「可視光」と呼ばれるヒトの目で見える波長域の光と、そのすぐ近くの赤外「近赤外」と呼ばれる領域の光を集めています。可視光と近赤外をセットとして同一衛星で観測するのが主流です。

光学センサでは太陽光を反射した対象物の”色”が見えています。あくまで、光の反射をみているので真っ暗な夜や雲のあるところでは撮影することができません。

詳しくはこちら:課題に応じて変幻自在? 衛星データをブレンドして見えるモノ・コト #マンガでわかる衛星データ https://sorabatake.jp/5192/

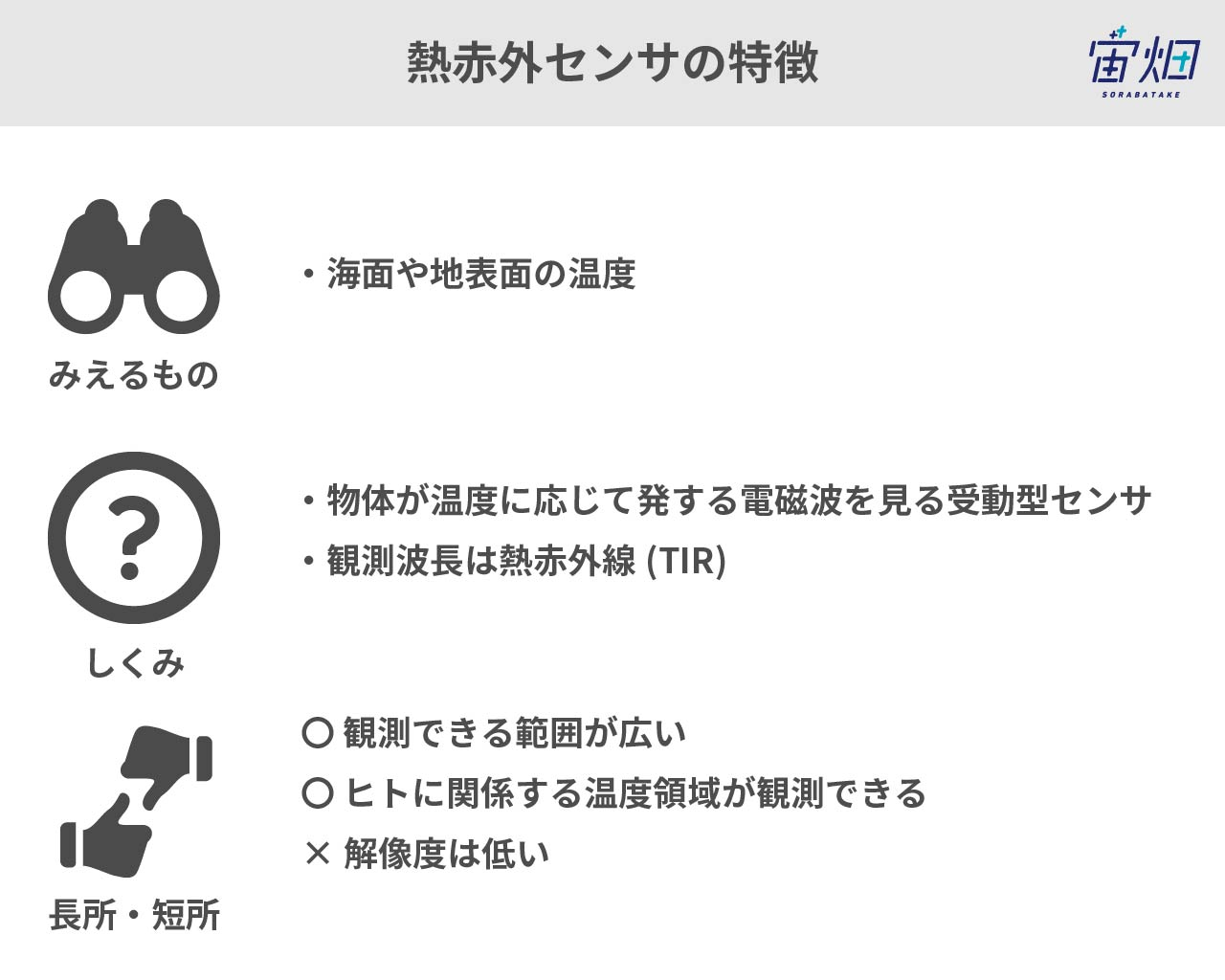

11. 熱赤外センサ

可視光よりも長い波長域を見ているのが、熱赤外線で、地表面の温度を観測します。

熱赤外線は物体自身が発する電磁波をみているので、地熱や林野火災はもちろんのこと、夜でも撮影することができます。

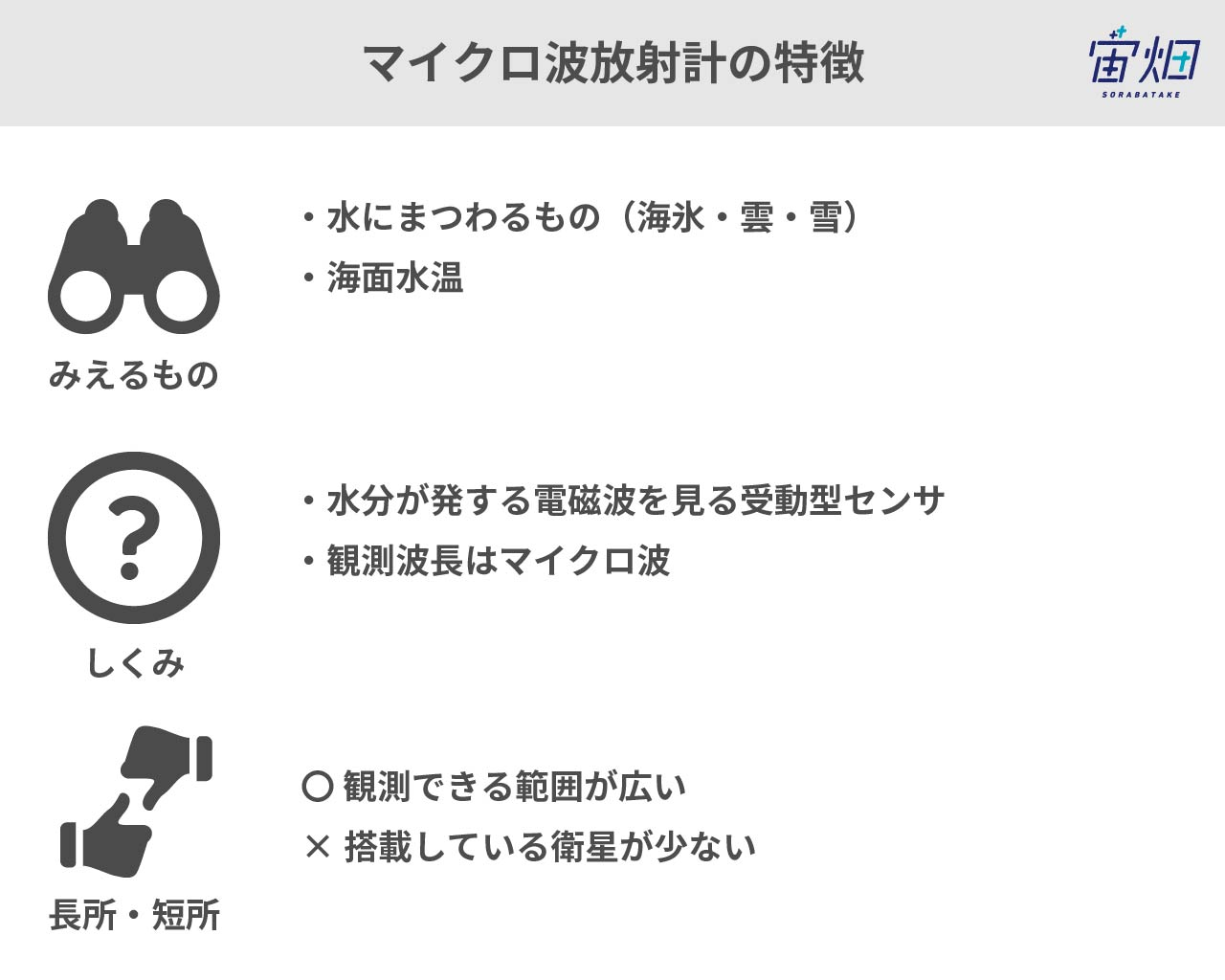

12. マイクロ波放射計

マイクロ波を受動的に観測するのが、マイクロ波放射計です。気温分布や大気中の気体の吸収特性,水および氷粒子の吸収・分散特性などが観測できます。

マイクロ波の特性から観測範囲は広いものの解像度は低く、搭載している衛星は少ないですが、気象予報などに幅広く使われています。

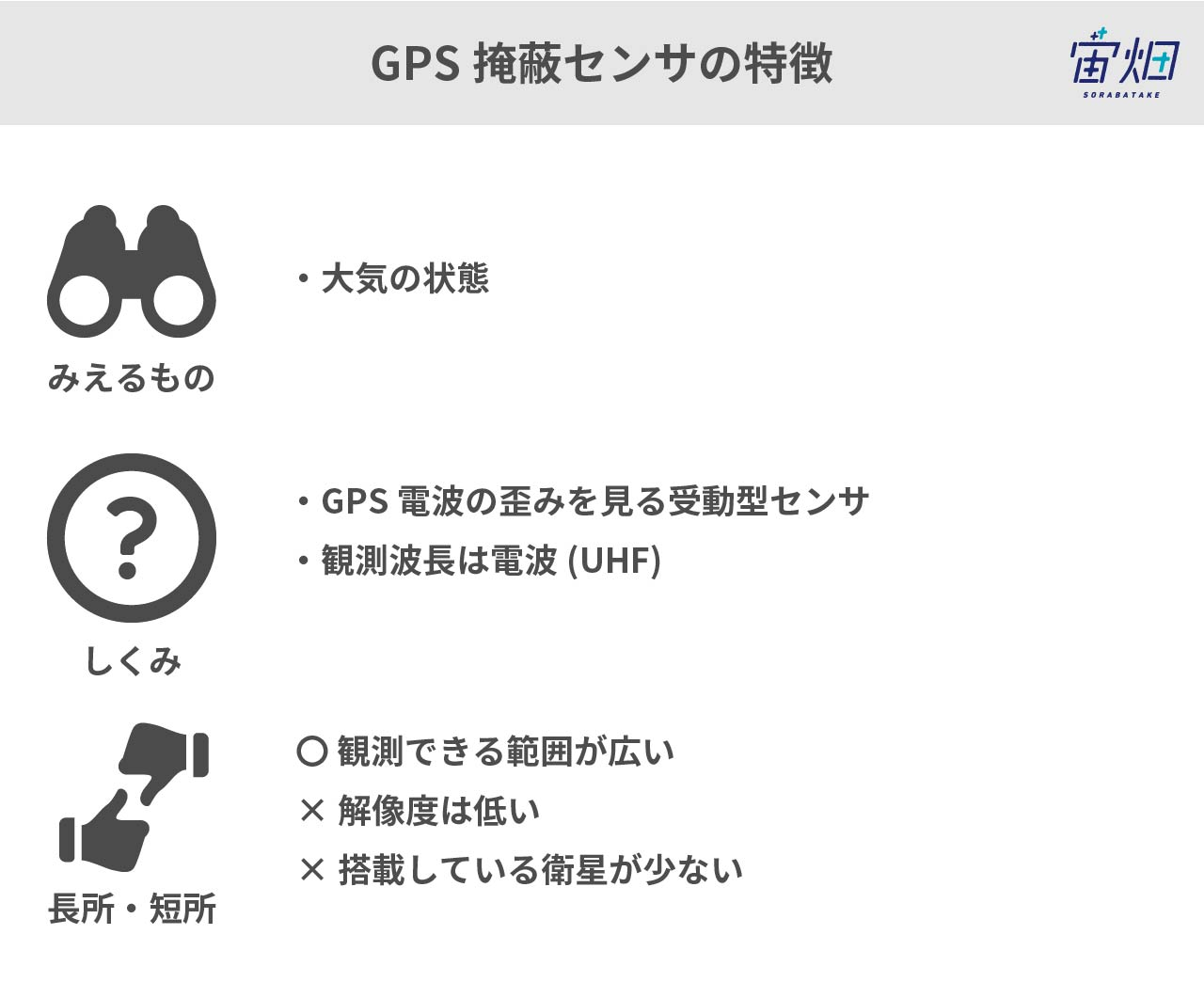

13. GPS掩蔽(えんぺい)

降雨レーダーのようなことをGPSの電波の散乱具合を使って観測するのがGPS掩蔽(RO:Radio Occultation)です。

電波の発射を自らが行わなくて済むため、衛星自身を小型化できるというメリットがあります。大気の状態を観測できるため、観測データを用いることで気象予報の精度を向上できます。

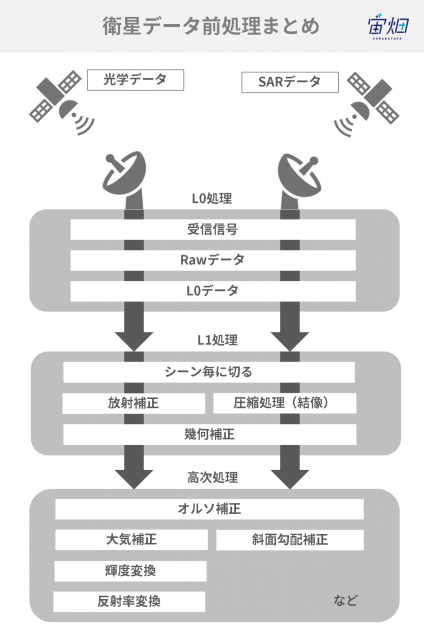

14. データが届くまで

処理の流れをものすごく大雑把に言うと、図のように、L0処理→L1処理→高次処理の3つのフェーズに分けられます。

L0(えるぜろ)の”L”は、Level(レベル)のことで、処理のステップを意味します。L1(えるわん)から2, 3などとレベルが上がることで処理は高次に進んでいきます。

衛星データを扱っていると耳にする「標準処理」という言葉は、衛星データのプロバイダ(供給元)が公式に出している処理のことで、データごとにL1処理だけのこともあれば、高次処理まで含む場合もあります。

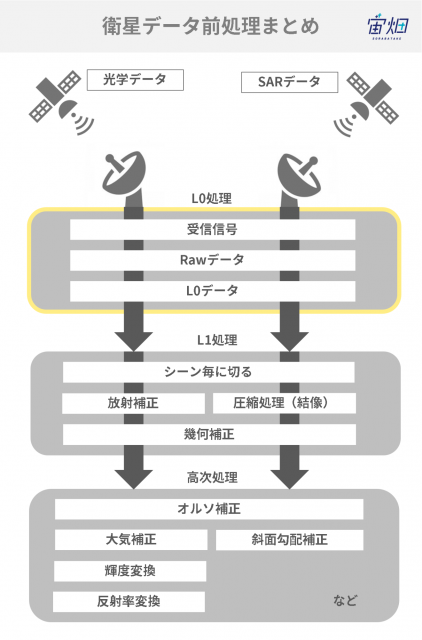

15. L0処理について

L0(えるぜろ)処理とは衛星からデータを受信して最初に行う処理のことです。

L0処理の中を詳しく見ていくと、

①衛星からの電波を地上のアンテナで受信する

②受信信号は伝送向けに加工が行われているので、元の信号(Rawデータ)に戻す

③Rawデータから余計な情報を削ぐ(L0データ)

というステップです。

世の中でも良く使われる「Rawデータ」という表現ですが、衛星データにおける「Rawデータ」とはこの②の状態のデータを指し、私たちが触ることはほとんどないデータである点に注意が必要です。

L0処理は、各衛星固有の設計に基づいて行われるため、衛星を所有する企業・機関で行われることがほとんどです。

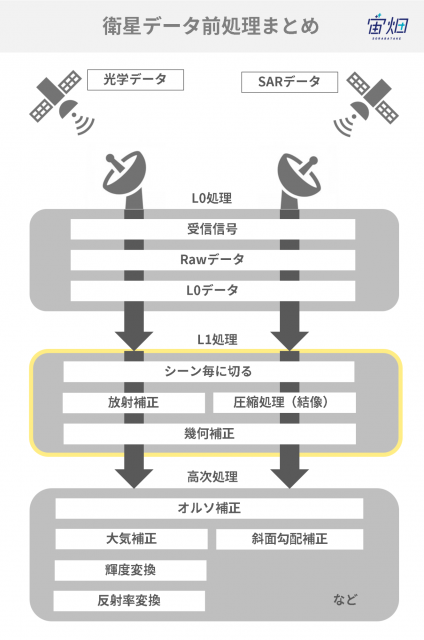

16. L1処理について

L1(えるわん)処理とは、どの衛星に搭載されたセンサーであってもほぼ共通する、レベル0からレベル1の基本的な処理です。

L1処理は大きく、

①シーン毎の切り出し

②画像の感度調整/結像して絵にする

③画像の歪みの除去

の3段階に分けられます。

これらの処理も各衛星特有の処理となるため、衛星を所有する企業・機関で行われることがほとんどです。

それぞれについて詳しく見ていきましょう。

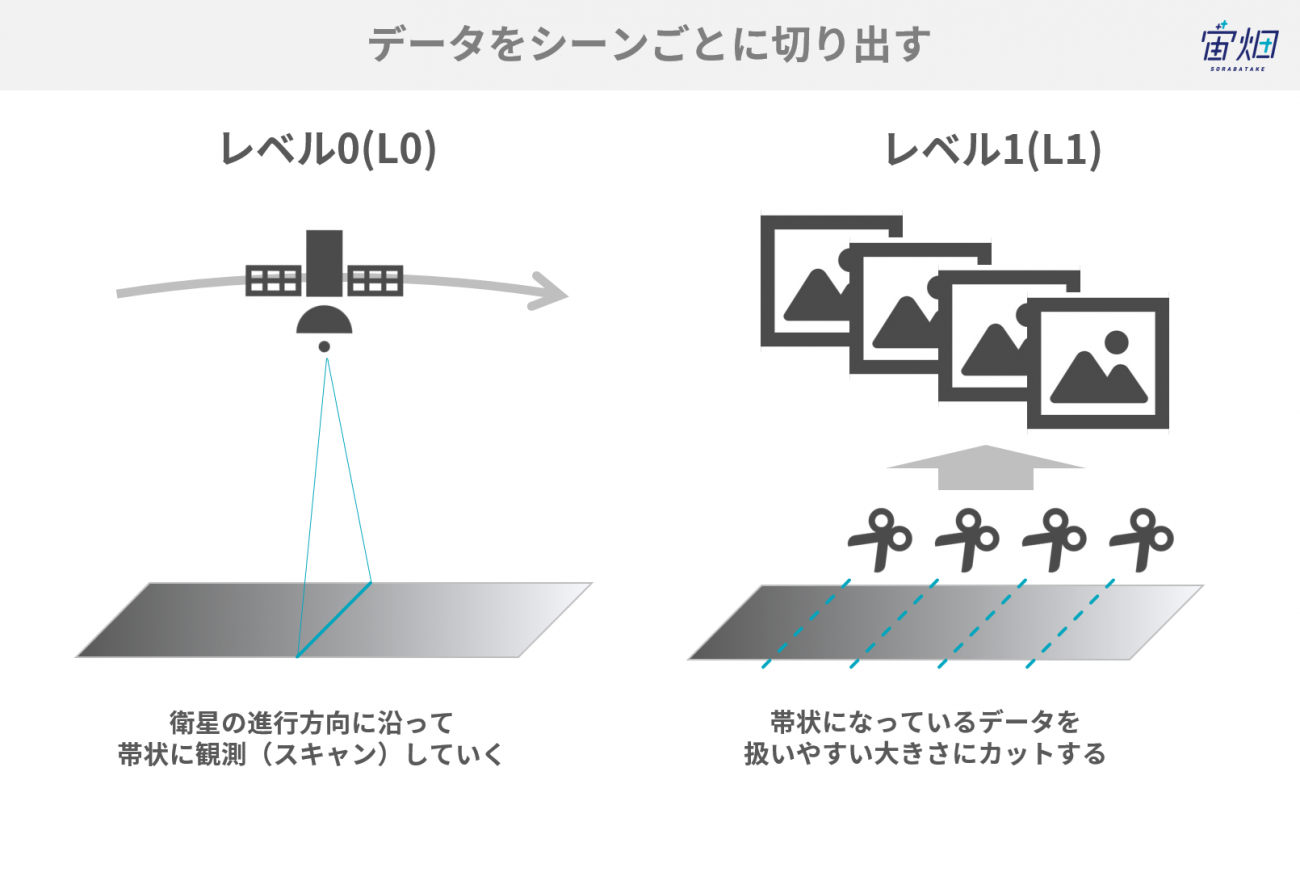

シーン毎の切り出し

まず行うのは、衛星が飛んでいく順に観測(スキャン)された帯状のデータを、”シーン”という写真一枚一枚に切り出す処理です。

こうすることにより、後段で処理がしやすいデータ量になります。

例えば、ALOSに搭載されたAVNIR-2というセンサでは、このレベルのことをL1A(えるわんえー)と呼んでいます。後段の処理に必要な情報(パラメータ)も一緒に提供されるので知識があれば、この後の処理も可能です。

後に説明する様々な補正をする前のデータのため、初心者の方には向かない画像かもしれません。

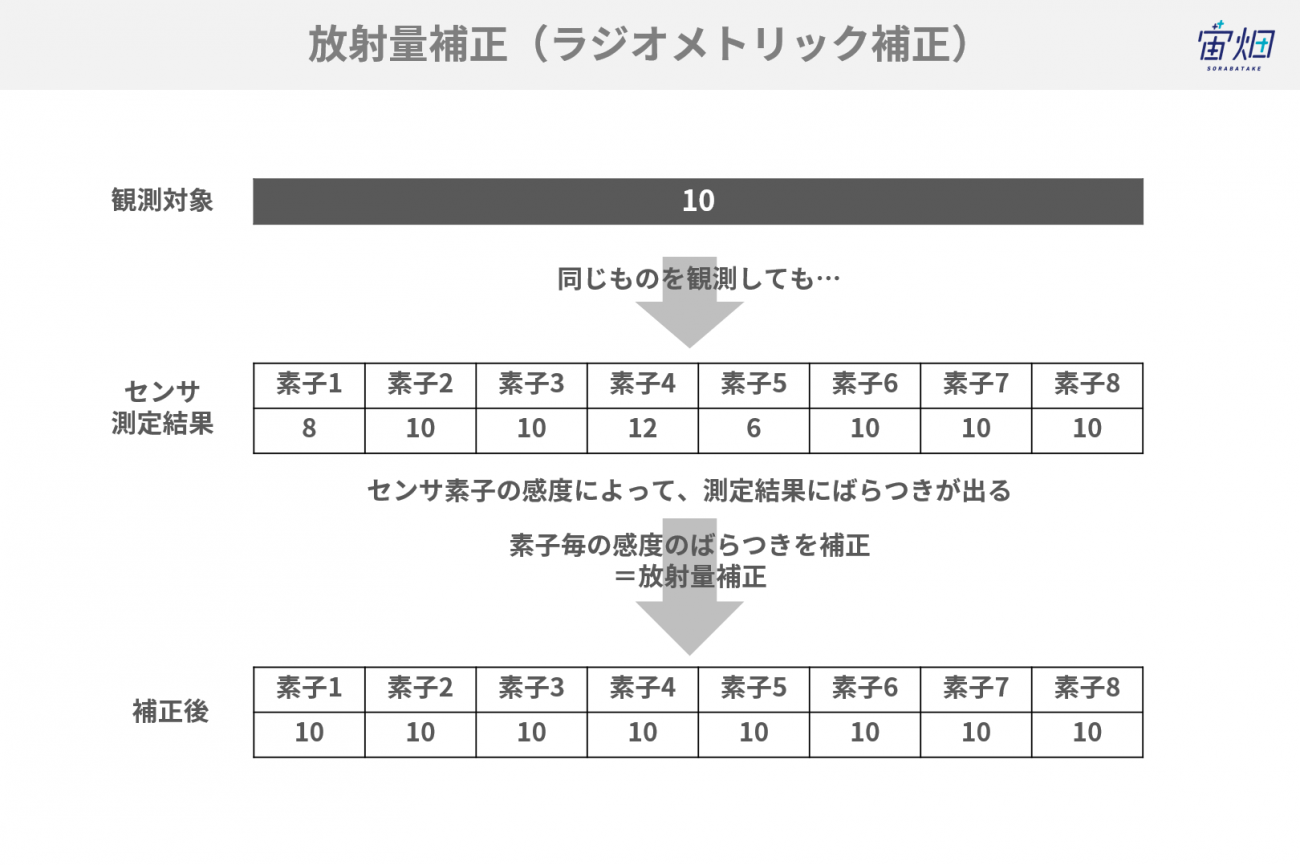

放射補正(感度調整)

調子の悪いコピー機の出力で、画像に線が入ったりするのを見たことがありませんか?

衛星のセンサでも観測する際に、それぞれの素子やビームの性質にばらつきがあると綺麗な画像になりません。斑のない綺麗な画像にするための補正が、放射量(ラジオメトリック)補正です。

衛星打上げ前にセンサのチェックをして補正の仕方を決めておきますが、打上げの際の振動や熱環境によって感度などが変化してしまうこともあります。その場合は、実際に観測されたデータから、正しく補正ができるように再調整をします。

この処理レベルを、JAXAのAVNIR-2(あぶにーるつー)というセンサの場合L1B1と呼んでいます。

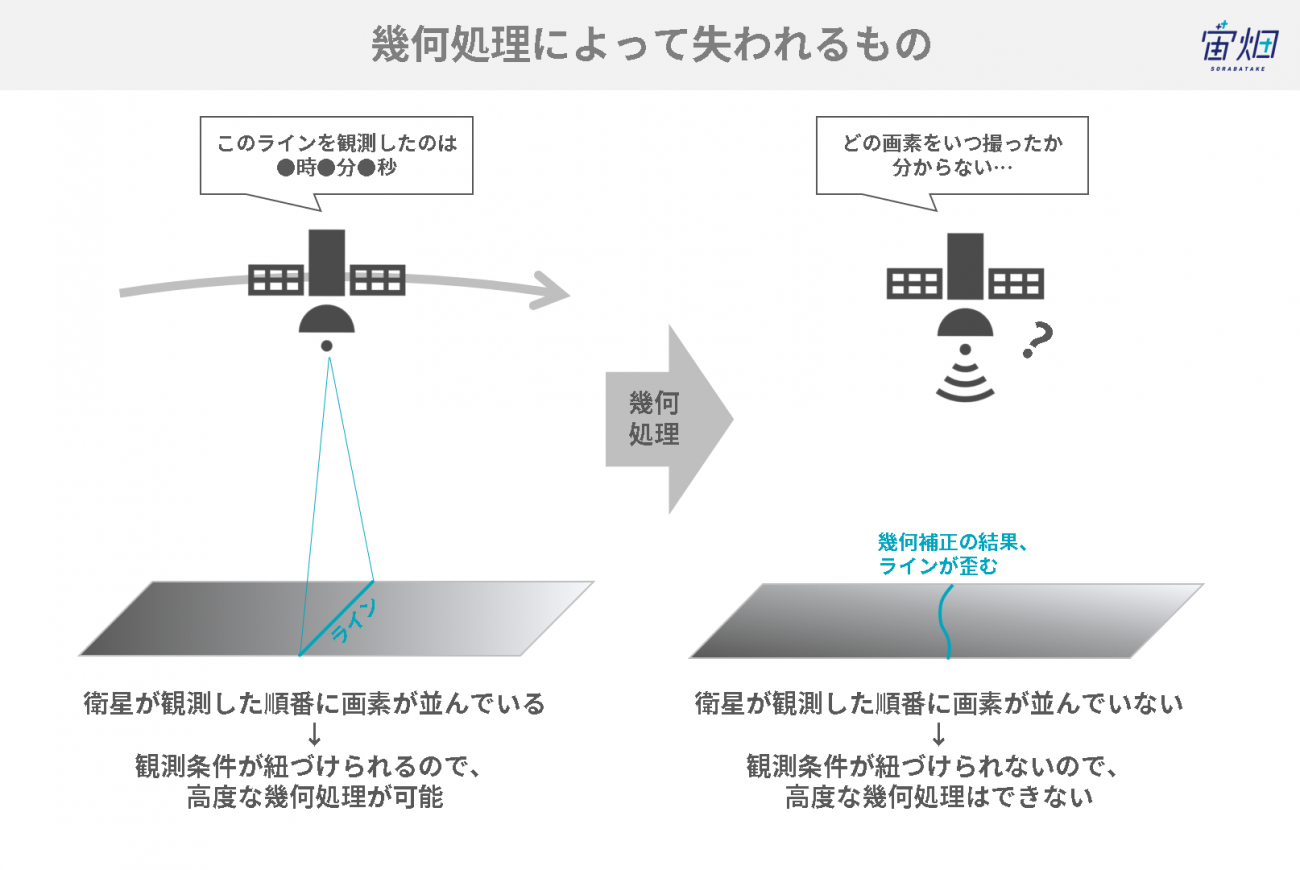

この後の処理では幾何的な補正を行うため、L1B1データは衛星が撮影した順番通りに画素が並んでいる最後の状態です。

高度な幾何処理を自分でやりたい場合には、どのタイミングで撮影されたかという情報を必要とするため、1B1を使います。

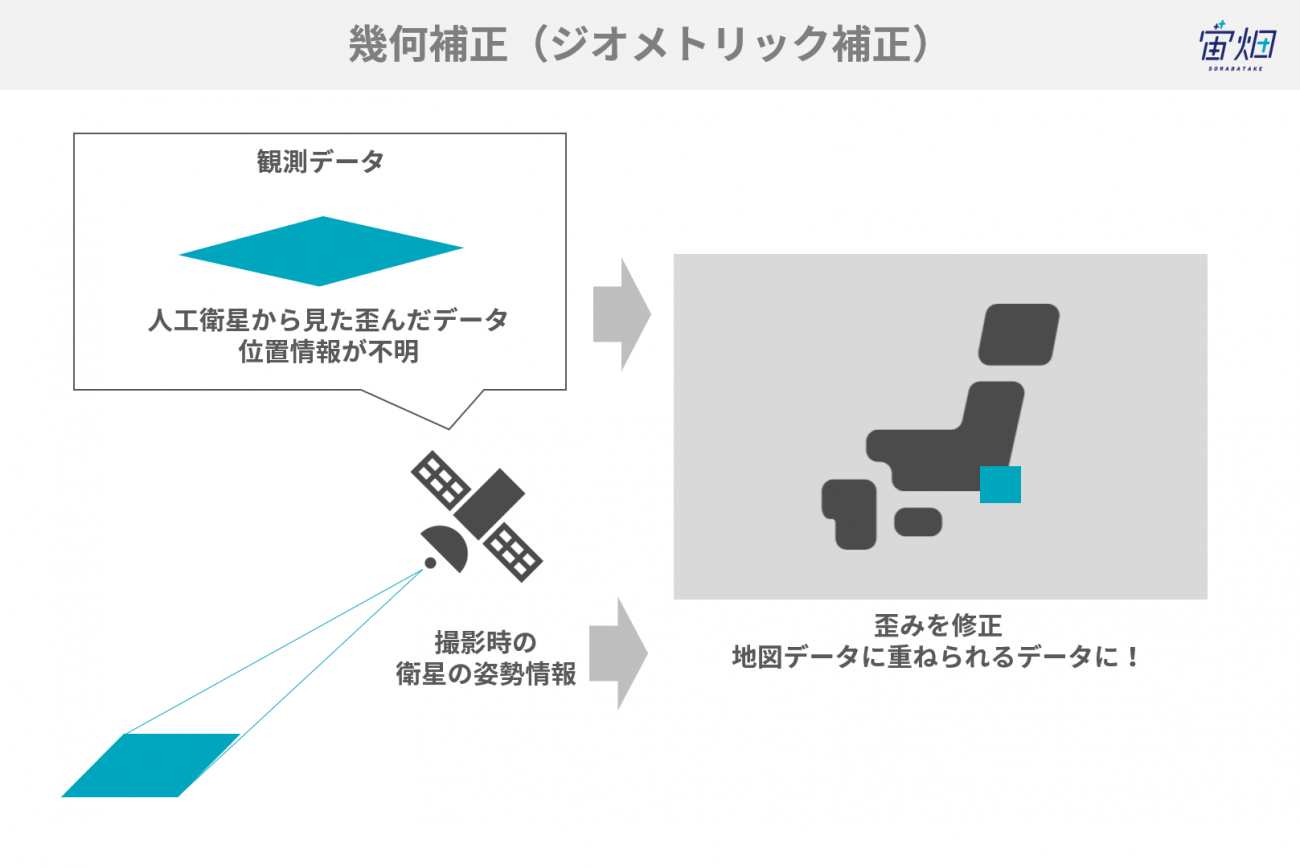

画像の歪みの除去(幾何補正)

人工衛星は様々な方向を向きながら広範囲を一度に撮影をしているため、撮影したデータには歪みやズレがあり、そのまま地図に重ねることはできません。

幾何補正とは、観測した画像が歪みなく、きちんと地図に重なるように変形させる処理のことです。

衛星がどの位置からどの方向を観測しているかという情報から、画像に位置情報を計算して幾何的な歪みを補正します。

同時にセンサー固有の歪み(主にスキャン方式などによる)なども補正しています。

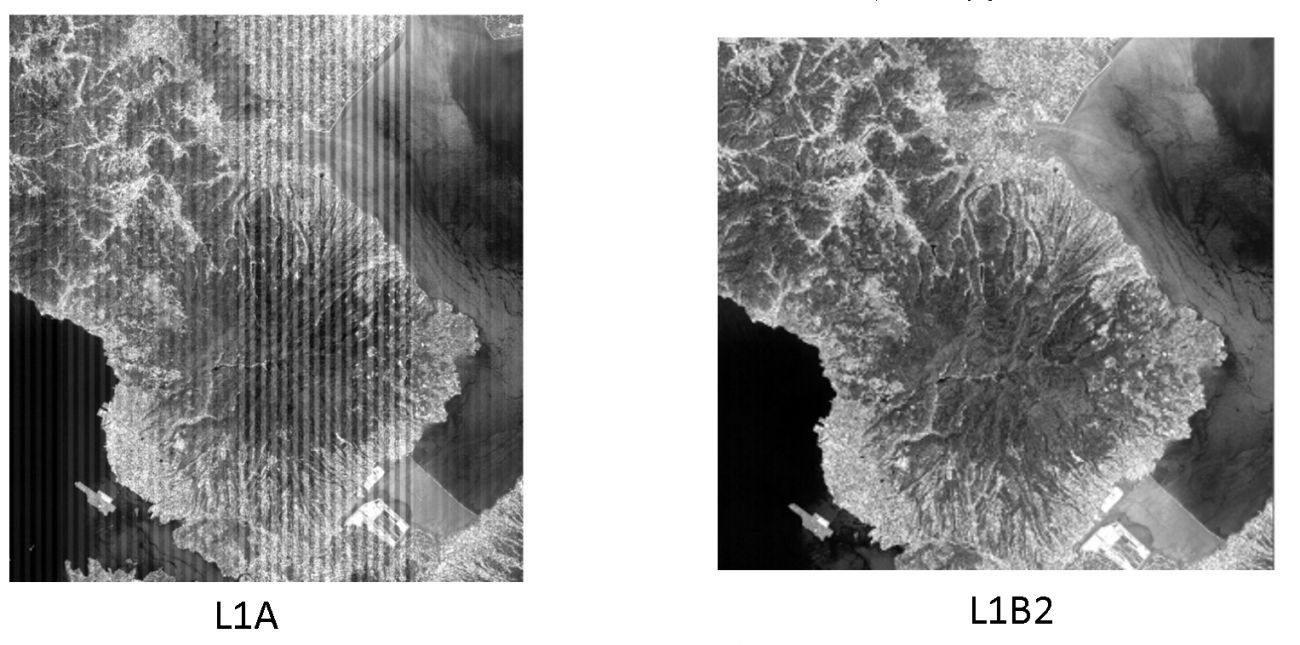

ALOSの画像を例に見てみましょう。

L1A(左)は画像に縞が残り歪んでいますが、幾何補正したL1B2(右)になると縞が取れゆがみも直っているのが分かると思います。

ここまで来てようやく、画像として綺麗で且つ歪みがない画像が出来上がります。

Credit : JAXA

17. 高次処理について

オルソ補正と大気補正、輝度変換、反射率変換について見ていきましょう。

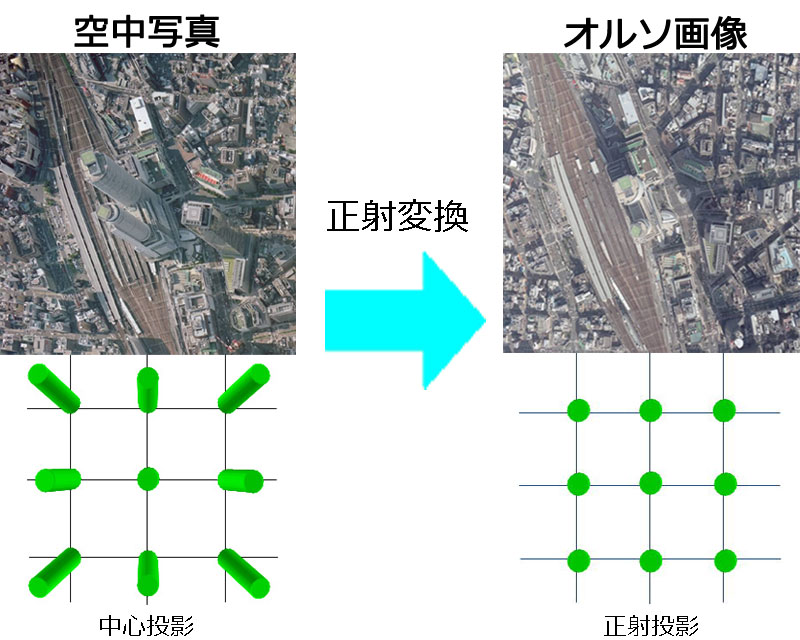

オルソ補正

オルソ補正の例(画像は航空写真)

Credit : Geospatial Information Authority of Japan

オルソ補正処理とは、背の高い建物や山など標高が高い対象物が斜めに見えてしまう対象物を真上から見たように戻す処理のことです。それによって地図にぴったりと合うデータになります。

商用衛星ではこのオルソ処理が標準化されつつあり、この状態での利用が一般的です。

オルソ処理は万能に感じるかもしれませんが、一つ落とし穴もあります。それは見えないものは見えないということです。例えば山の斜面で衛星を向いている側はよく見えます。反対斜面は見えていません。

オルソ補正は、見えない部分は近傍のピクセルを使って埋めて幾何的に正しい位置にしているので、見えない部分の情報は不確実にならざるを得ない場合があります。現場で画像判読を担当する方はその辺りも十分頭に入れながら活用しています。

大気補正

サンフランシスコのSentinel-2データの補正前(左)と補正後(右)の画像。

Credit : ヘキサゴンジオスペーシャル c/o日本インターグラフ株式会社

「光学データ」の場合、地表面の様子は大気を挟んで観測されます。したがって、得られるデータは大気の影響を受けています。

大気補正は大気による散乱や吸収による効果を仮定して、これを相殺する処理です。

大気補正をすることによって、大気の状態に依らない地表面での明るさを得ることができます。

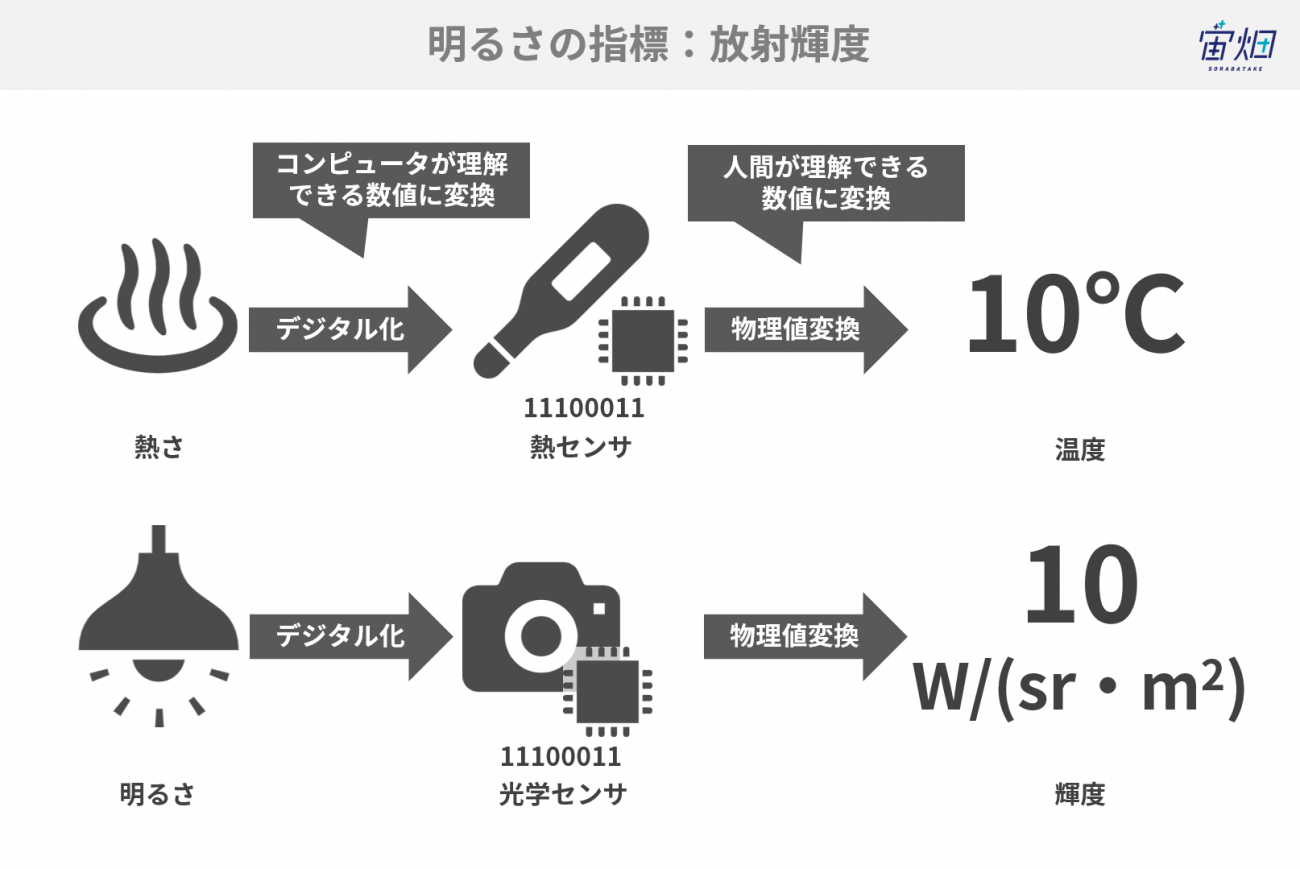

輝度変換

温かさの指標が「温度」であるように、光学データが示す明るさの指標は、「放射輝度」と呼ばれています。

元々のデータの持っている値は「放射輝度」にはなっていない整数値(8bitであれば0から255までの数値)です。

この値を、センサ毎に与えられた数式に当てはめることで、「放射輝度」を求めることができます。

※この処理自体は高次処理ではなく、L1プロダクトの持つ数値を物理量に直す処理です。

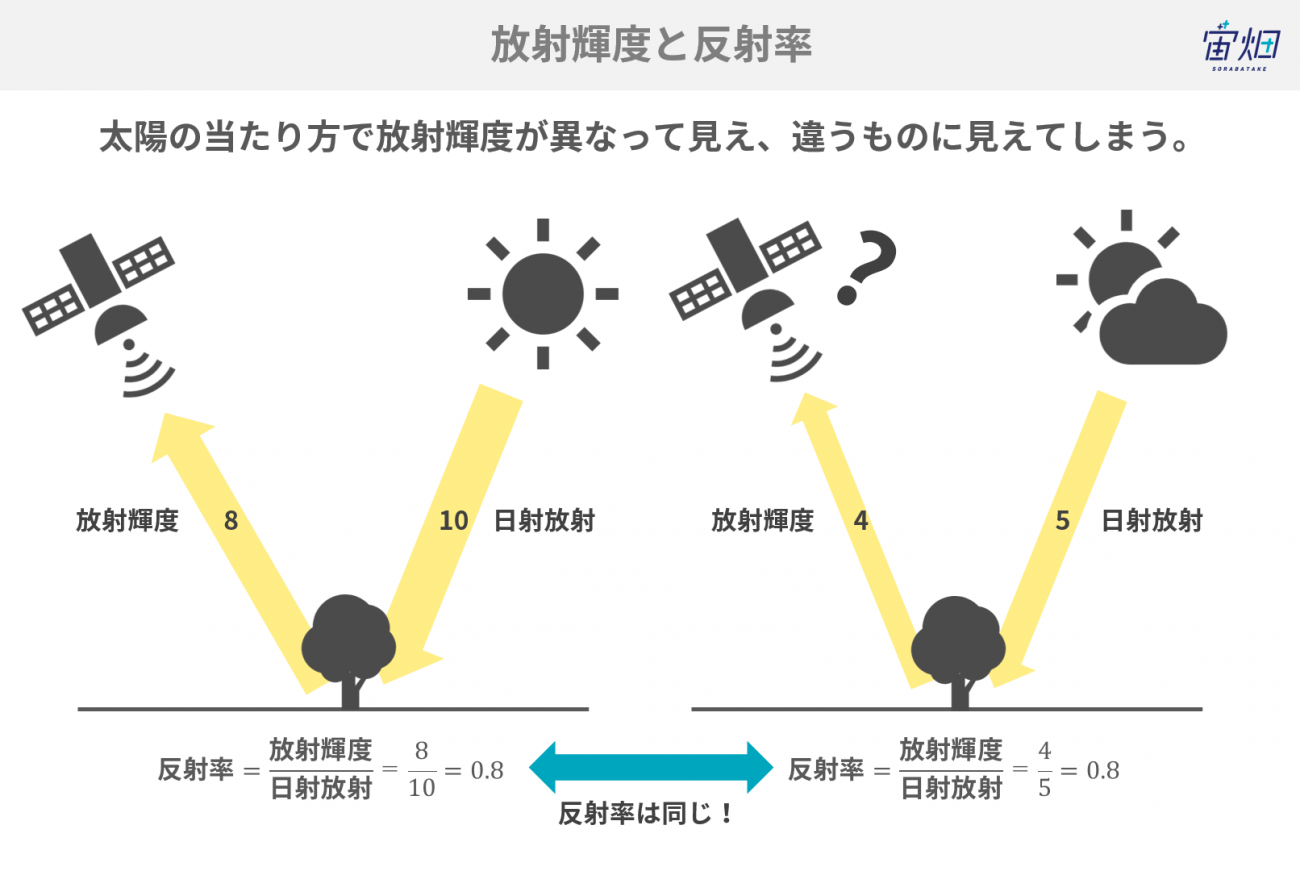

反射率変換

太陽光の強さ・当たり方の違いによって、地表面の放射輝度は変わってしまいます。

例えば、赤道付近と北極付近では太陽の照り方が違いますし、季節によっても異なります。その差を小さくするために衛星で観測した放射輝度/日射放射という反射率(Reflectance)を求める場合もあります。

これも、大気補正をして地表面での反射率(Surface reflectance)と、衛星が観測した放射輝度の反射率、つまり大気上端での反射率(Top of Atmosphere (TOA) Reflectance)があります。

詳細は「【図解】衛星データの前処理とは~概要、レベル別の処理内容と解説~」をご覧ください。