リモートセンシング導入

1. リモートセンシング導入

リモートセンシングとは、地球の表面における情報を人工衛星や航空機により遠隔的に取得する技術です。具体的には対象からのエネルギー反射・放射を人工衛星のセンサにより捉え、取得した情報に対して目的に応じた処理・解析をして利用するまでを含んだ一連のプロセスとなります。

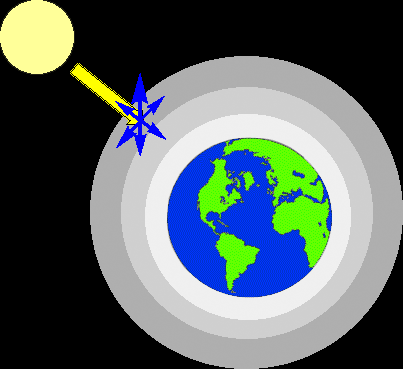

A: 発光体やエネルギー源:興味のある対象物に対して電磁放射を与える発光体(例えば太陽)やエネルギー源が存在しなければ、リモートセンシングを行なうことはできません。

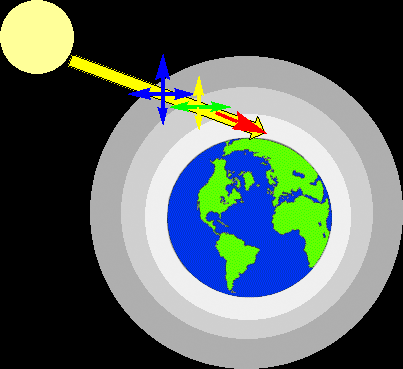

B: 放射と大気:太陽表面や人工衛星から放射されたエネルギーは、大気と相互作用しつつ大気を通り抜けます。これは、観測対象物が反射したエネルギーが人工衛星のセンサに受け取られる際にも生じます。

C: 対象物質との相互作用:対象物の物理特性や化学特性に応じて、反射や放出されたエネルギーが人工衛星のセンサによって観測されます。

D: センサーによるエネルギーの測定:対象物からエネルギーが反射、散乱、放射された後、人工衛星のセンサは、その電磁放射を収集・記録するために用いられます。

E、F: 伝達、受信、処理:センサによりエネルギーが感知された後、電子信号が地上局に送られます。信号データ処理され、画像として出力されます。この処理には複数の段階を踏まなければならず、詳細については別のチュートリアルで説明をします。

G: 解釈、解析、利用:出力された画像は様々な処理を通して、目的に応じた情報が引き出されます。衛星リモートセンシングを通して得られたデータは、地上でのみ獲得された情報では入手しえない広範囲で均一な情報を提供することが可能となります。データの利用は多岐に渡り、様々な分野で活用することができます。

2. 電磁放射(電磁波)

リモートセンシングにおいて、対象物に照射するエネルギー源は重要なものになります。エネルギー源は電磁放射として観測されます。これは太陽の光や地球による放射のどちらかでも見られるものであり、もちろん人工衛星からの照射でも観測が可能です。電磁波は電場(E)と磁場(M)が互いに直交し振動しながら進行するエネルギーの流れのことです。そのエネルギーを電磁エネルギーと言います。

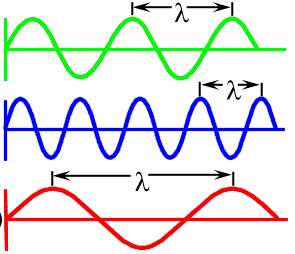

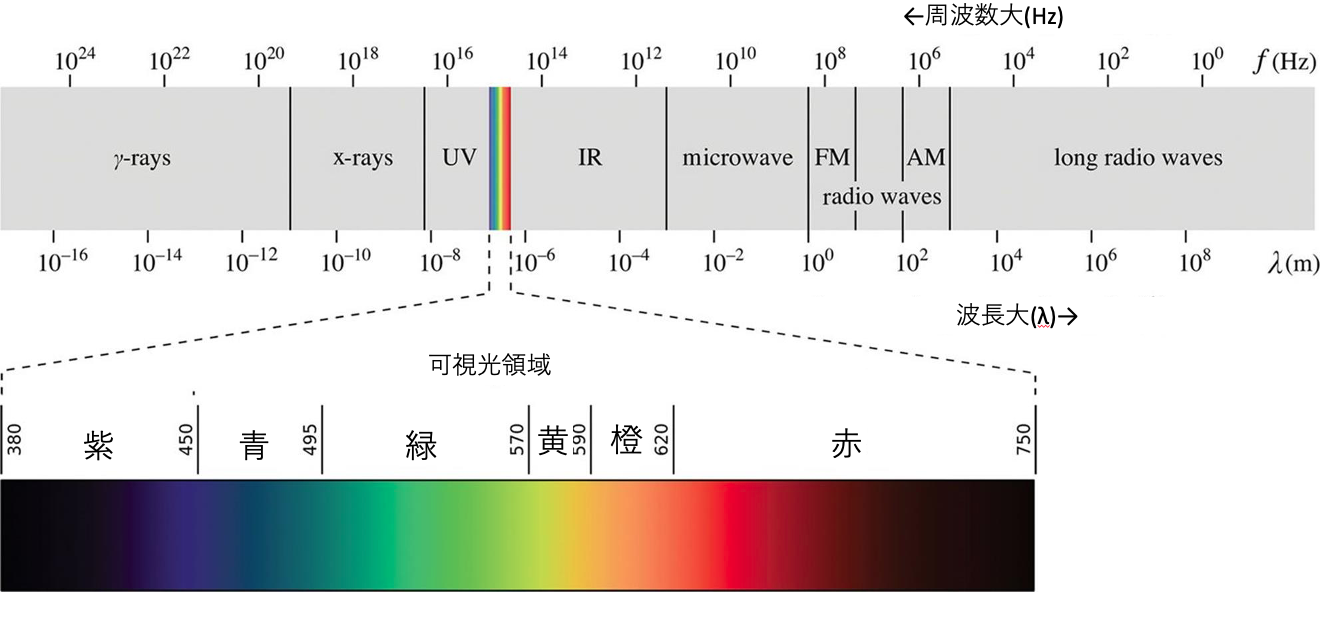

波長とは波の山から山までの(一つの波のサイクル)距離のことです。波長はλで示されることが普通で、ミリメーター(mm)やナノメーター(nm)の尺度をよく用います。

上図では、電磁波における周波数と波長の関係を示しています。波長が短ければ周波数は高くなり、波長が長ければ周波数は低くなります。周波数は一般的にヘルツ(Hz)で表されます。光は全てが同じ速度で進みますが、その波は上のように互いに異なっています。詳しくは次の説明を参照して下さい。

3. 電磁スペクトル

多くの人が目にしている衛星画像は、スマートフォンやデジタルカメラで撮影した画像とほぼ変わらないように見えます。しかし、衛星画像は単なる写真と異なった情報をもっています。スマートフォンやデジタルカメラでは、被写体からの光を集め、結ばれた像が撮影素子(センサ)において電子データとして処理されます。出力された画像は私たちの目で捉えたものと変わるところがありません。一方で、衛星画像は様々な波長(人の目で捉えられる波長、そして捉えられない波長のデータを含みます。この可視光波長帯でない波長データを含めているということが衛星画像と写真の違いで重要な部分です)を測定したものが組み合わされて表現されています。そのため肉眼で捉えられない情報も画像として映し出すことができます。

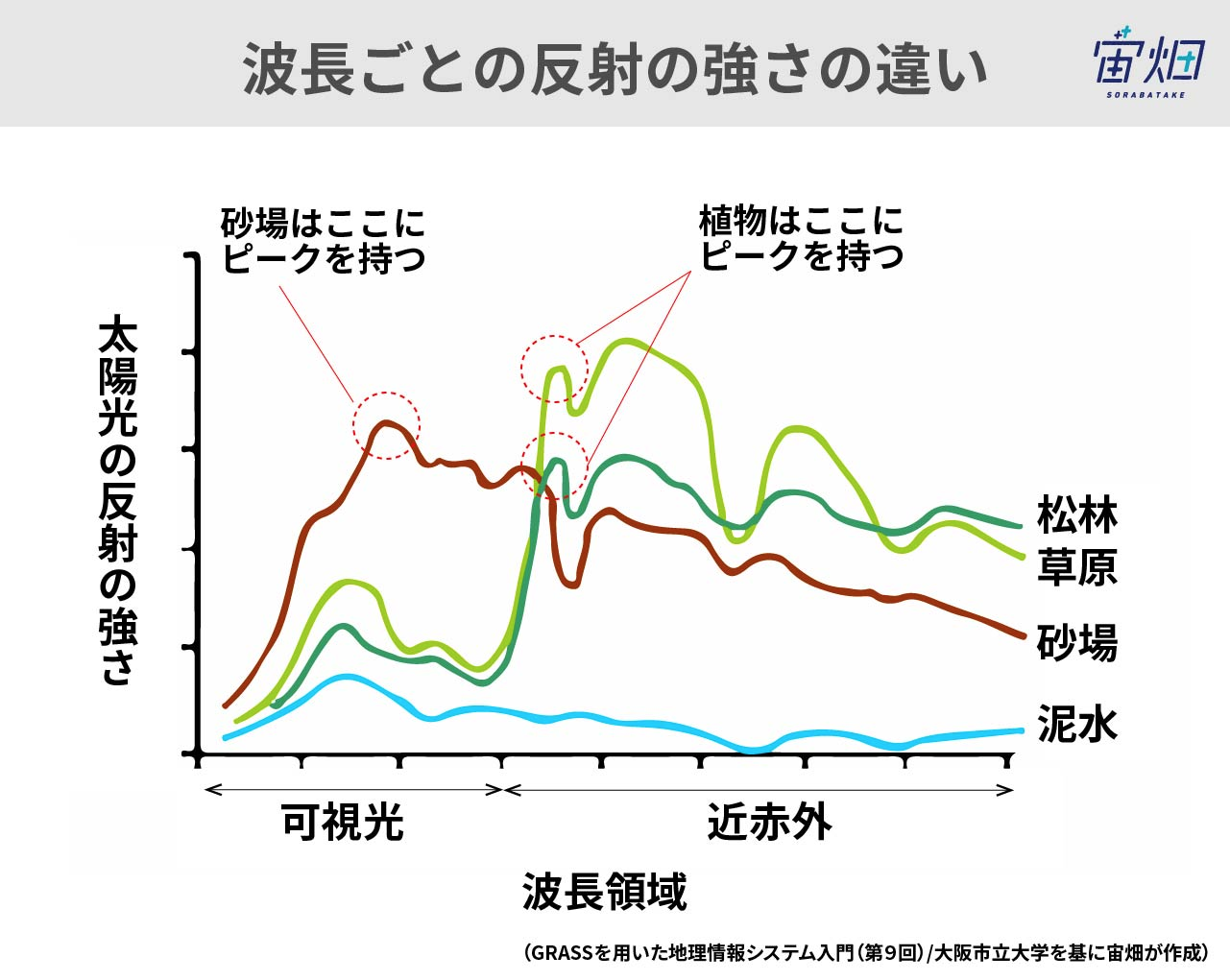

地球表面の全ての物質は各々の相互作用に応じて、光を特徴的に吸収、放射、そして反射します。例えば、植物に含まれる葉緑素は赤や青の光を吸収しますが、緑や赤外光線は反射します。この反射特性のため、植物の葉は私たちの目に緑色に映るのです。このような物質に特有の吸収や反射のパターンを、スペクトルシグネチャ(spectral signature)と呼びます。

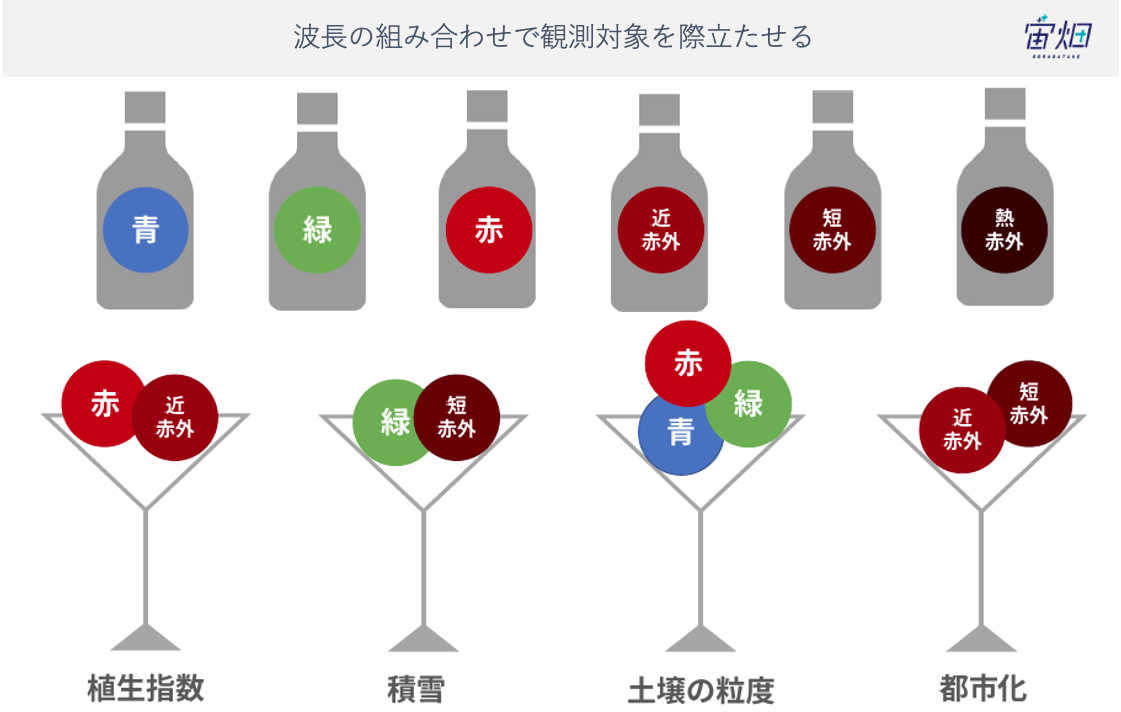

どのような波長の組み合わせが、どのようなものを目立たせることができるのでしょうか。簡単な例になりますと、上のような図で説明することができます。上の例で示された植生指数は厳密には、マルチスペクトル画像(複数の波長を合成した画像)とは異なるものですが、植物が近赤外線をよく反射し、赤色の波長は吸収するという特性を活かして作成された画像となります。波長の合成により作成された画像では、トゥルーカラー画像やフォースカラー画像が代表的なものになります(下図参照)。

Original data provided by JAXA

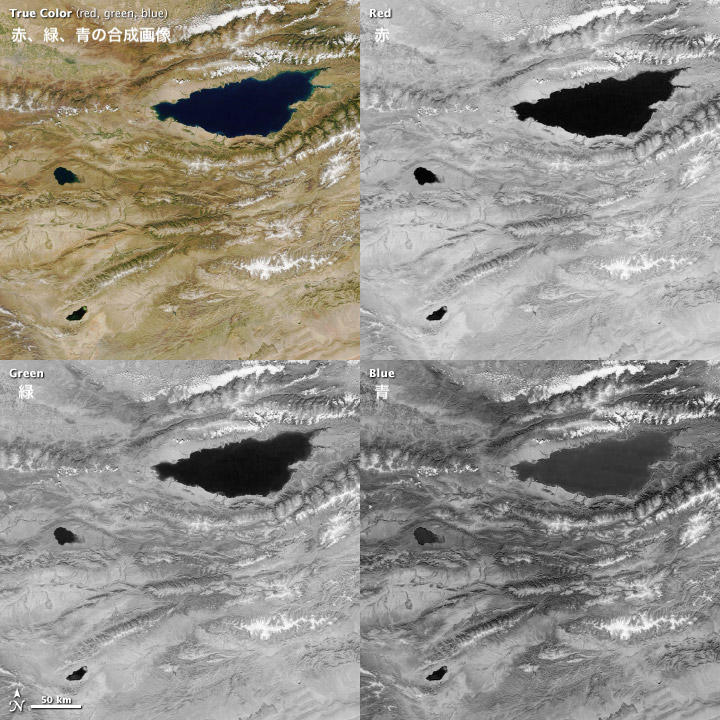

トゥルーカラー(True color)と呼ばれる組み合わせ。赤、緑、青(RGB)の光で組み合わされています。人間の目で捉えた世界に似た画像となります。

Original data provided by JAXA

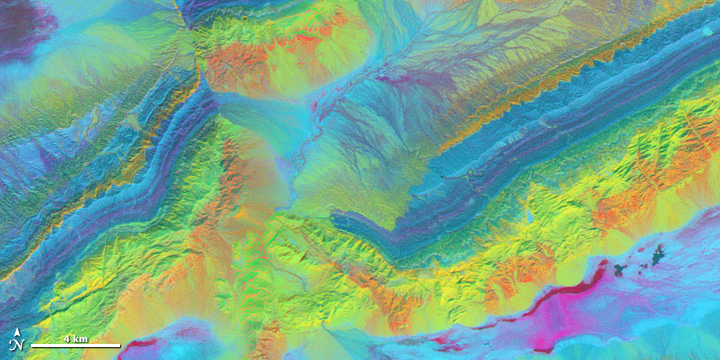

フォールスカラー(False color)と呼ばれ、Rに短波長赤外線、Gに赤、そしてBに緑の波長を割り当てた画像です。このイメージでは赤に割り当てられた遠赤外線の反射が異なるため、植物がどの程度よく成育するのか、そしてどの程度生い茂っているのかを考えることが可能になります。例えば植物は遠赤外線をよく反射するため暗い赤で示されています。その一方で、成長が早い植物は、より多くの遠赤外線を反射するため明るい赤色を呈することになります。水は黒か青で表現され、都市域は銀色(白色)となります。代表的なフォースカラーは近赤外(R)、赤(G)、緑(B)で割り当てられたもの、短波赤外(R)、近赤外(G)、緑(B)を割り当てられたものなど、赤外波長が含まれているものとなります。対象物の波長に対する反射特性により、同じフォースカラー画像でも異なった見た目を作成することができます。

| 名称 | 波長帯 | 説明 |

|---|---|---|

| 可視光 | 0.4-0.75 μm | 多くの観測衛星で用いられている波長帯です。0.4 – 0.446 μmが紫。0.446 – 0.500 μmに青。0.500 – 0.578 μmに緑。0.578 – 0.592 μmが黄色。0.592 – 0.620 μmが橙色。0.620 – 0.7 μmが赤色。 青、赤、緑が光の三原色と言われる、混色のベースとなります。 |

| 近赤外 (NIR) | 0.75-1.5 μm | 地表面の状態や雲に含まれる氷晶などに対してそれぞれ特徴的な反射の性質を有しています。可視光領域、近赤外、中赤外領域は人工衛星で非常に多く用いられています。 |

| 中赤外 (MIR) | 1.5-5 μm | 雲の検出や分類などといった、大気観測に用いられます。地表の観測として、火山活動のモニタリング、山火事といった熱源の検出や、海洋の表面温度の測定にも使われています。 |

| 熱赤外 (TIR) | 5.0-15.0 μm | 中赤外と同様に熱源の検出を得意とします。地表における氷の被覆の変化を捉えることにも用いられています。 |

| マイクロ波 | 1mm-1m | 雲を通り抜けるため、天候に左右されず観測が可能となります。マイクロ波には受動型と能動型の二種類があり、受動型では地球表面や大気中の水粒子が放射する微弱な電磁波を観測します。能動型では衛星自体がエネルギーを放ち、対象物から反射される電磁波を観測することになります。 |

可視光領域

青色の波長(450から490 nm)は、大部分が水に吸収されます。この波長帯では、水面の特徴を見ることや、海や湖の浅いエリアを抽出することに役立つことがあります。都市や道路などの人工物も青色の光でよく捉えることができます。空が青く見えるのは、青色の波長が大気中の気体分子で散乱するためです(詳しくはレイリー散乱で説明します)。

緑の光(490から580 nm)は、植物プランクトンや植物を観測することに長けています。これらの生物に含まれる葉緑素は赤や青の波長を吸収しますが、緑の波長は反射するためです。水中の沈殿物も同様に緑の光を反射することで知られています。水中の泥や砂の層は青と緑の波長をどちらも反射するため、他の対象物より鮮やかに映ります。

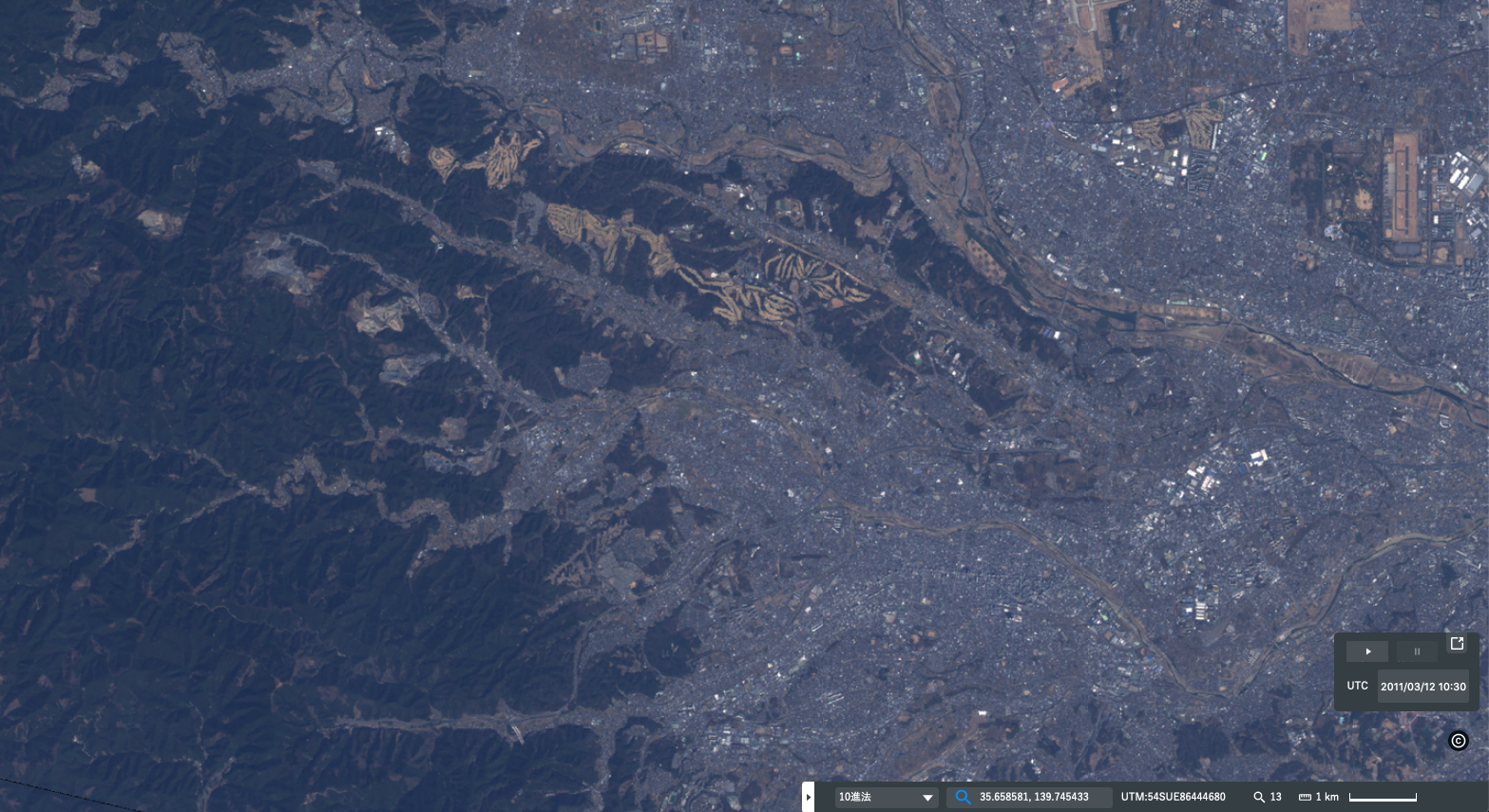

赤色の波長(620から780 nm)は、鉱物と土壌を判別する助けとなります。例えば、上の画像では土壌が薄い褐色から濃い褐色(ややオレンジがかっている)を呈しています。この色の変化は土壌中に鉱物の含有量に影響を受けています。また、クロロフィルは赤色を吸収しますので、植物(農作物を含めた)の成育状態をモニタリングすることにも使われます。赤色の波長は細かく判別をすることには向きませんが、植物の分類を行なう場合にも利用することができます。

赤外領域

赤外線は可視線の波長に近い方から、近赤外、中間赤外、熱赤外などと分類があります。資料によっては近赤外と中間赤外の間に短波赤外を定義していたり、中間赤外の次が遠赤外となるなど、分類が多少異なっています。

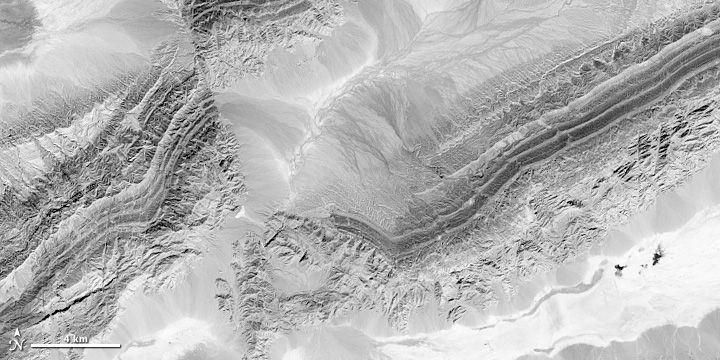

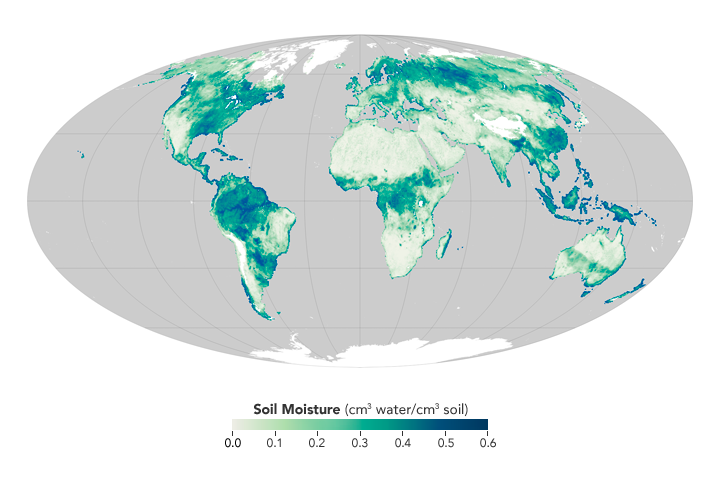

近赤外線(NIR)は700から1,100 nmの波長域を含みます。水は近赤外線をよく吸収するため、可視光領域では明確にならない陸域と水域の判別をする際に役立ちます。例えば上図では、河床や湿地(図左上隅の部分)が周辺の乾燥地より暗い色で表現されており、そこに水が存在していることがわかります。植物は対照的に近赤外を強く反射し、特に健康状態の良い植物ではそれが顕著なります。この波長は大気中のチリなどを通り抜けるため、もやがかったような画像の詳細を捉えることにも適しています。 短波赤外(SWIR)領域は1,100から3,000 nmの範囲にあります。1,400、1,900そして2,400 nmの三つの領域では水は短波長赤外によく吸収されます。例え土中であっても、その水分量を濃淡で表現することが可能です。SWIRは土壌や植物中にどのくらいの水分が含まれているのかを見積もる場合に役立ちますと言えます。SWIRでは雲のタイプを区別するのにも使えるだけでなく、雲、雪、そして可視光では単に白くしか映らなかったものを判別する場合にも有用となります。加えてSWIRは熱に対する感受性が高く、燃焼が生じた土地でより反射されます。この特徴により火事が起こった際、その被害を進行を調べること可能になります。岩石に含まれるミネラルは各々が異なった反射特性を持ち、これもSWIRを用いて観測することが可能です。下図では砂岩や石灰岩で構成された山岳地帯をSWIRを利用して画像としたものです。それぞれの岩石に含まれるミネラルの含有量に対して、異なった色調で表現されていることがわかります。

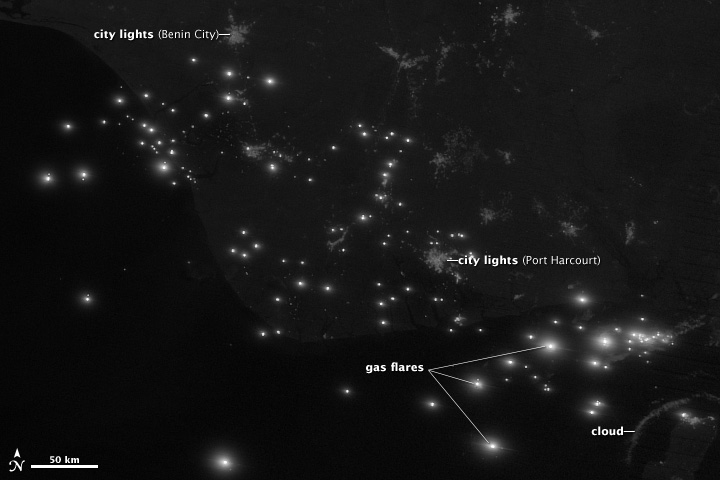

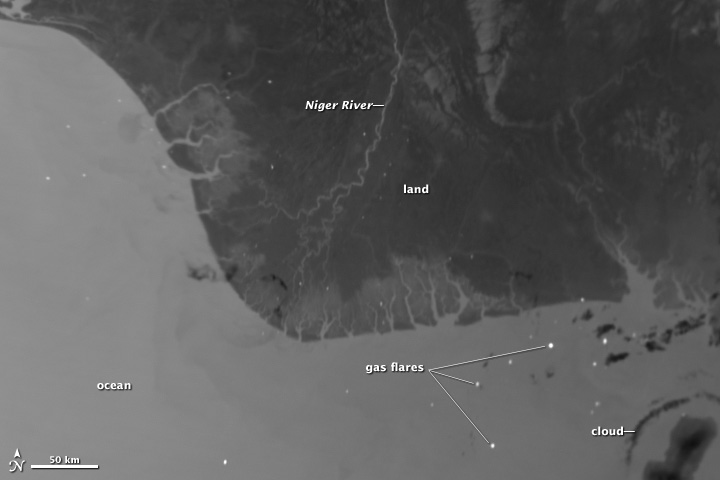

中波赤外(MIR)は3,000から5,000 nmの範囲にあり、主として夜間における熱放射を観測するために用いられます。この波長は海の表面温度、雲や火事を調べるためにも使用されています。下図では夜間において、同一地点を可視光領域(上図)と中波赤外領域(下図)の波長を用いて観測したものです。1つ目の図(上図)では放射・反射された光のみが観測されています。一方、2つ目図(下図)では夜間で冷えた地面や雲は暗く、相対的に暖かい海や川が白く表現されていることが分かります。

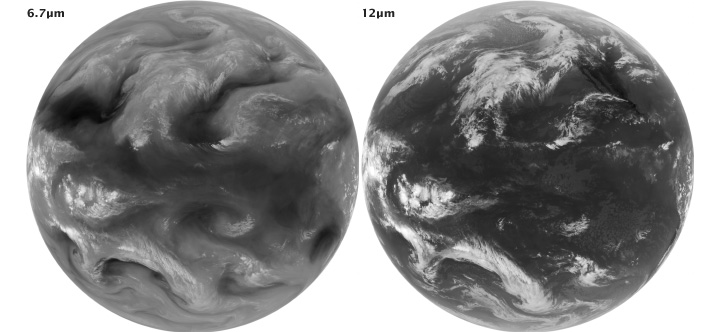

6,000から7,000 nmの領域は、大気中の水蒸気を観測することに長けています。水蒸気は大気中に1%から4%程度しか含まれていませんが、重要な温室効果ガスの一つです。この特性により、気象の観測や予測に不可欠な情報を与えるものとみなされています。下の図ではこの領域と熱赤外を用いて、水蒸気量(左)と気温(右)を示したものです。

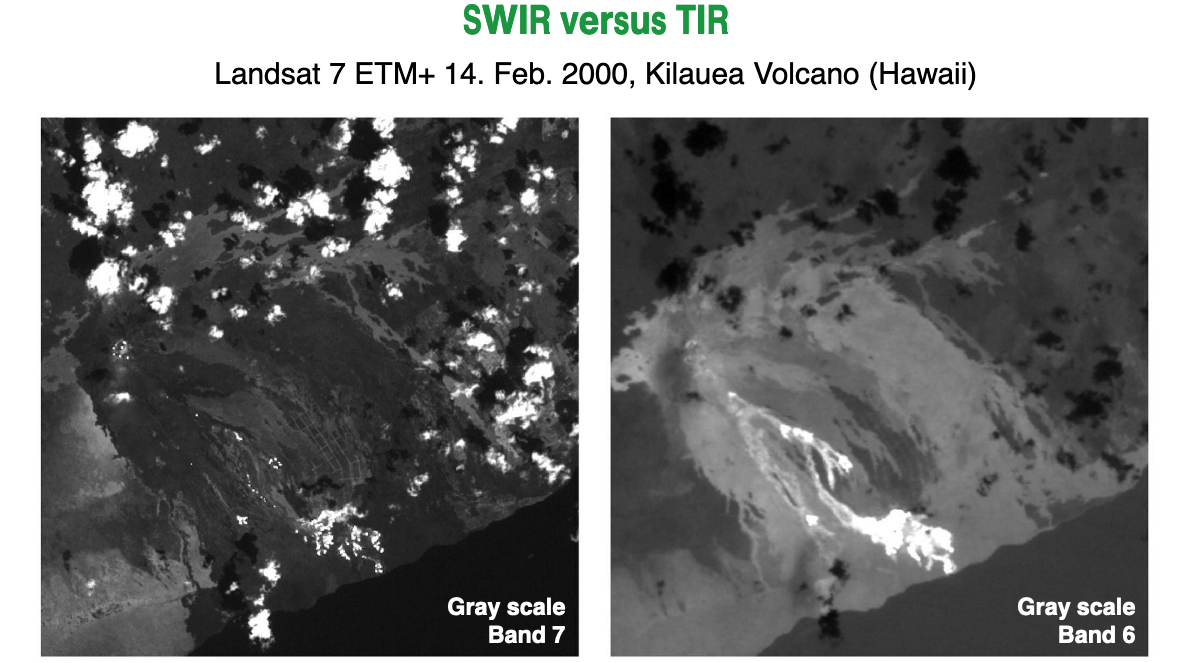

熱赤外(TIR)もしくは長波赤外(LWIR)は、8,000から15,000 nmを含んだ領域の波長です。この波長は、地球から熱として放出されたものです。この波長帯では水を捉えたり、地表面温度を捉えることに用いられ、地熱のマッピングや火事など、熱を放出している対象を捉えることに向いています。下図では同一地点をSWIRを用いた衛星画像とTIRを用いた画像で比較したものです。左図(SWIR)に比べて右図(TIR)では溶岩をはっきりと捉えていることがわかります。加えて、植物が蒸散を通して大気中に放たれた水蒸気が、その上空の空気を冷やすことを利用し、植物がどのくらいの水を利用したのかを調べるためにも用いられることがあります。

マイクロ波領域

マイクロ波によるリモートセンシングでは、能動と受動の二つのタイプが存在します。マイクロ波は、約1 cmから1 mの範囲にある波長です。可視光や赤外領域と比べ長い波長を持ち、そのため雲や大気中のチリにより地面が捉えづらい場合でも、それらを通り抜けて観測をすることが可能です。なぜなら、マイクロ波は大気における散乱の影響を短い波長領域のように受けることがないというためです。マイクロ波はどのような天候下、さらに夜間でもデータを収集することが可能であるという利点があります。

3. 大気との相互作用

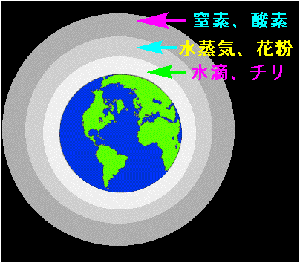

地球は大気の層で包まれています。この層内には窒素や酸素を中心とし、様々な分子で構成されており、これを空気または大気と呼んでいます。大気は気体分子だけでなく、水蒸気や氷晶、チリなどの微粒子、そしてバクテリアも含んでいます。太陽光はこのような大気の中を通り抜けるため、理論上進むであろう方向を阻害され不規則に進んで行きます。この現象を散乱と呼びます。

厳密には光と微粒子の間におこる相互作用を散乱と定義し、散乱の程度は、光の波長(λ)と微粒子の大きさ(d)によって決定されます。微粒子の大きさが光の波長より十分に小さい場合(λ << d)にはレイリー散乱 (rayleigh scattering)が生じ、散乱の度合いは波長の4乗に反比例します。厳密に言うと、光の波長が粒子より大きい場合、光はその粒子に反射をされることはありません。しかし、気体分子は極性があるため光に対して影響を与えます(光は電磁波の一種)。青い光は窒素や酸素分子で散乱し、さらに散乱された光は散乱を繰り返し(多重散乱)、空全体を青く染め上げます。私たちの目に空が青く映るのはこのためです。

同様に空が赤くなる理由もレイリー散乱により説明ができます。日中の太陽は真上から降り注ぎ、通過する大気層は短いですが、夕方は斜めに入り通る層は長くなります。青い光は、その途中で大半が散乱し、地球に届くのはわずかになります。一方で赤い光は散乱が少なく、相対的に地球に到達する量が多くなります。これが夕焼けの原因となります。

大気中の微粒子では水滴が相対的に大きなものとなり、水滴の集まりが雲あることが知られています。水滴は光の波長より大きいか、または同程度の大きさと考えられます。このような粒子により生じる散乱をミー散乱(Mie scattering)と言います。この散乱では可視光の波長が同程度に散乱を受けるために、対象物が白く映ります。温泉でも白く濁ったタイプがありますが、これも同様の原理で生じています。

非選択的散乱では、波長より大きな粒子に光が当たるときに生じます。ミー散乱と同様にすべての波長を散乱するため、対象物は白く映ります。空気中のホコリが良い例でしょう。この散乱では赤外線も含みます。太陽が雲に隠れてしまうと、暖かさを感じられなくなります。これは非選択的散乱が生じ、暖かさを感じる波長が届きにくい状態になっているためです。

4. 反射・放射(対象物との相互作用)

反射

対象物表面が光を受けた時、その一部は対象に吸収されます。吸収されなかった光は、対象物を反射するものと通り抜けていくものに分かれます。衛星では対象物が反射した光を各々の波長帯で別々に観測することになります。どの波長帯をどのくらい反射しやすいか、吸収しやすいかは対象物によって異なります。

放射

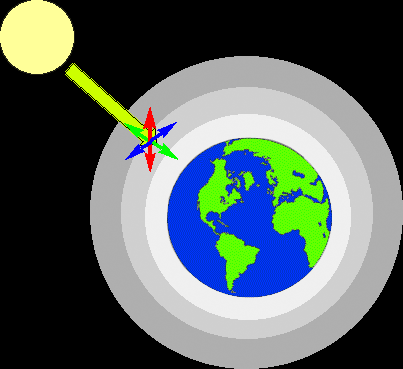

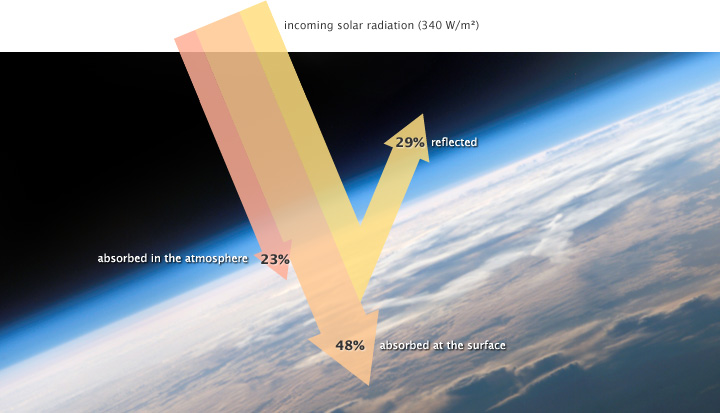

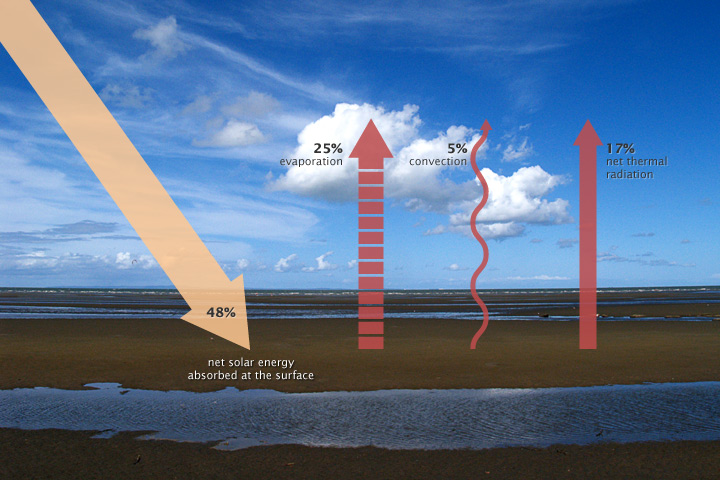

太陽のような発光体からエネルギーが放射されますが、全てが地球に届くわけではありません。例えば、太陽では地球に届くエネルギーはおおよそ半分になります。雲や大気中のチリ、または明るい地表面(雪や氷)によって反射され、大気中の水蒸気やチリやオゾンによって吸収されるためです。

地表まで届いた太陽のエネルギーは、さらに蒸発、対流、熱赤外エネルギーの放射によって地球の表面上から失われることになります。放射した熱赤外エネルギーは大気中に吸収されますが、大部分は大気を通り抜けて地球外へ向かいます。衛星はこのように地球表面から放射された一部のエネルギーも観測することができます。この放射されたエネルギーが十分出ない場合には、衛星のセンサで捉えることが難しくなります。

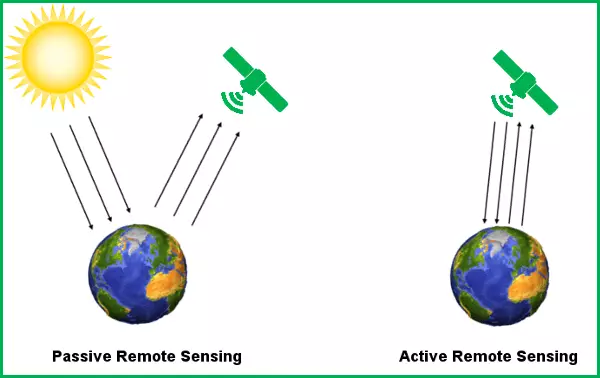

5. 受動・能動観測

エネルギー源や発光体から放出されるエネルギーを受けて反射・放射をする対象物を観測する人工衛星は受動センサを用いています。反射は太陽の光を受けている時間でしか利用できません。放射ではセンサが感知できるだけの十分なエネルギーを対象物が放出していることが観測可能な条件となります。

一方、能動センサでは自ら観測に必要なエネルギーを放出しています。放出されたエネルギーは対象物で反射し、センサで感知をされます。このセンサの利点は昼夜に関係なく情報を得ることができるという点です。能動センサでは昼夜関係なく情報を得るため、マイクロ波のような波長を用いています。欠点としては対象を「発光」させるために必要なエネルギーが大きく特殊なセンサが必要という点、得られたデータの解釈が難しいことが挙げられます。

6. 画像とは

衛星画像は人工衛星に取得したデータにより作成されたものです。衛星画像は特定の波長帯に応じてセンサが独立してデータを収集しているため、目的に応じて波長を組み合わせて解析をすることが可能です。得られたデータを処理し、画像にする過程の詳細については省きますが、画像化されたデータはHDFやGeoTIFFといったフォーマットで保存されています。最近では使いやすいCloud Optimized GeoTIFF(COG)といったフォーマットが盛んに利用されるようになっています。

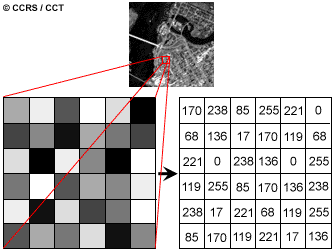

画像のデータはピクセルと呼ばれる等間隔に区切られた正方形の集まりで構成されます。各々のセルの中には、画像の輝度もしくは色調に関する情報が数値データとして割り当てられています。人工衛星のセンサは電磁波のエネルギーを測定し、数値情報を配列の中に記録していますので、それらの数値を用いて画像化(色調や色の濃淡として表現される)することになります。

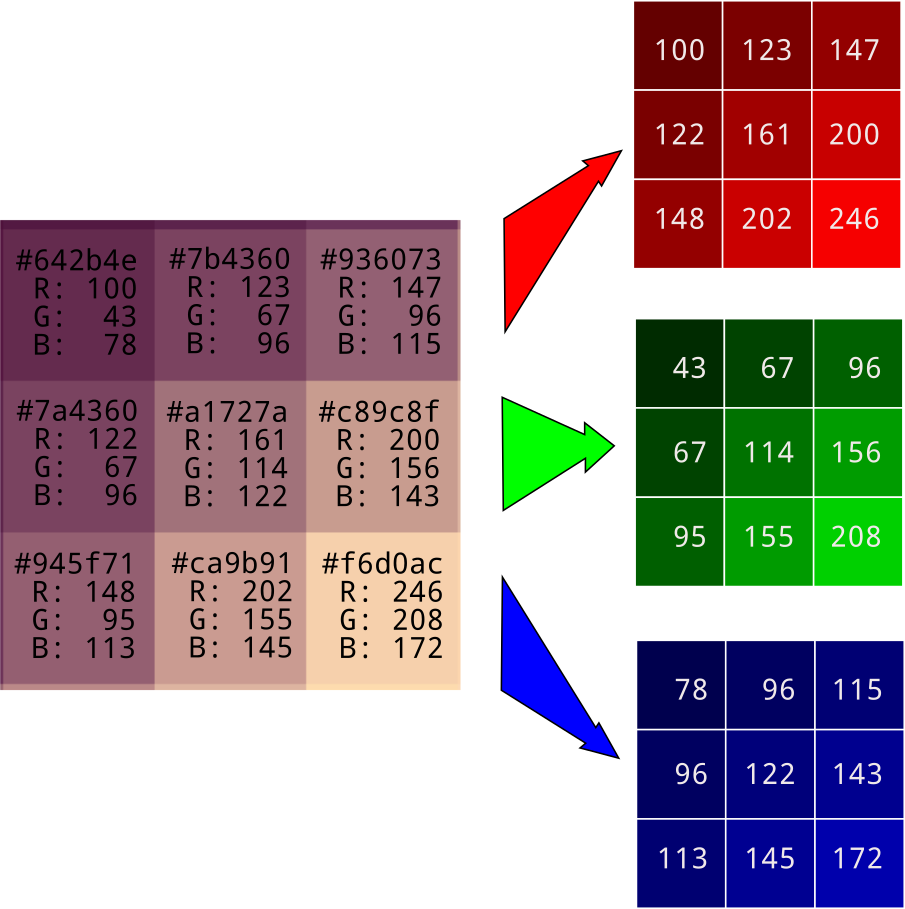

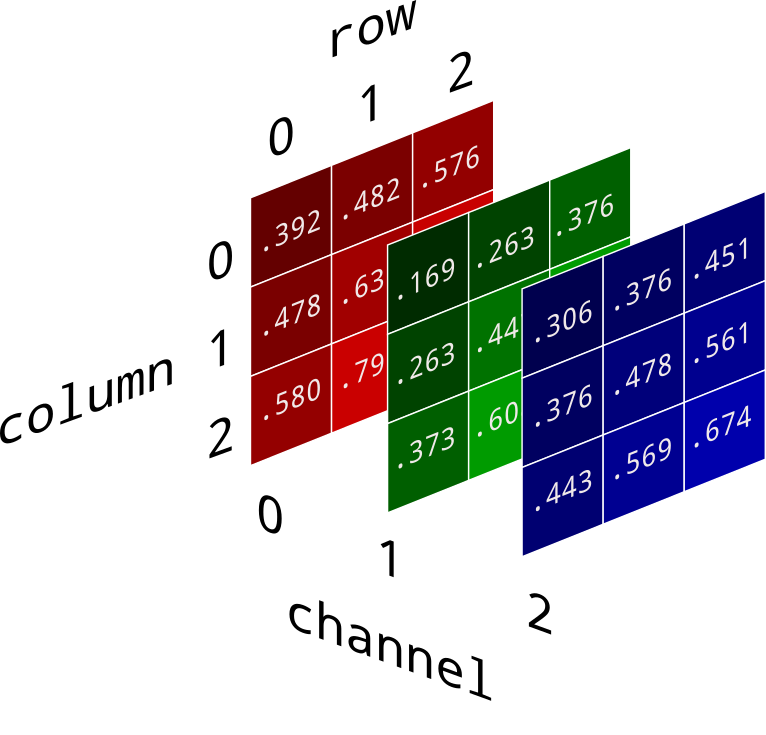

上の図では8bitのグレースケール画像であるため、値は0から255までの範囲をとります。カラー画像では、さらに高次元の配列を用いる必要があります(RGBにそれぞれの値が割り当てられることが必要です)。下図では9つのピクセルに対してRGB値が割り当てられています。このようにデジタルデータは数値情報により各々の色調を表現し、カラー画像を構成しているのです。

出典:https://brohrer.github.io/images_to_numbers.html

RGB値は上のように別々のレイヤー(三次元配列)に保持されています。プログラミング言語でデータを処理する際には、データが高次元配列に割り当てられているということを理解しておくことが必要です。 画像データに関する知識というものは、リモートセンシングで得られたデータを画像として表現する際に極めて重要な知識となります。センサが捉えた波長のデータは、RGBのセル中に波長ごとの値が割り当てられ画像となっています。複数の波長情報をもつ衛星画像では、対象物の反射特性を考慮した上で波長を選び画像を作成できるため、目的に応じて柔軟に対象を際立たせることが可能です。画像の解釈や解析については、画像解釈のチュートリアルを参考にしてください。

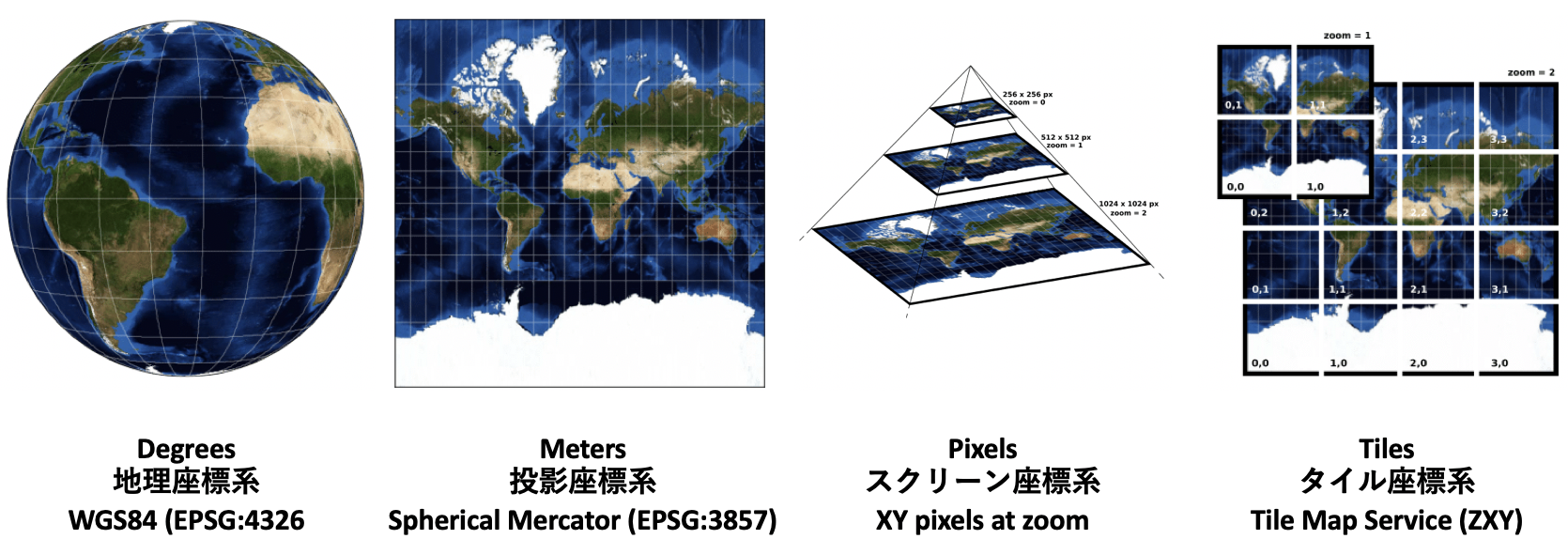

7. 座標、地図投影法、測地系

この項では始めに座標というものが何かについて説明をします。なじみ深いXY座標から始まり、地理座標、平面(直角)座標へと進み、UTM(Universal Transvarse Mercatol:ユニバーサル横メルカトル)座標系を説明します。続いて実際の地図投影方法へと言及して、最後に測地系を説明します。これらの説明を通して、衛星画像がどのように二次元平面上に投影されているのかを理解することができます。

座標

地球のある地点の場所を知るためには座標が定められていなければなりません。最も知られた座標系として、直交座標系(Cartesian coordinate system)があります。直交座標系では、原点を中心として、ある地点がX軸とY軸上のどの場所にあるのかを決定することができます。しかし、この系では地球上の位置を定義するには十分ではありません。そのため、地理座標系(Geographic coordinate system)という別の系を用いて、地球上の特定地点を定義することになります。

出典:https://www.esrij.com/gis-guide/coordinate-and-spatial/coordinate-system/

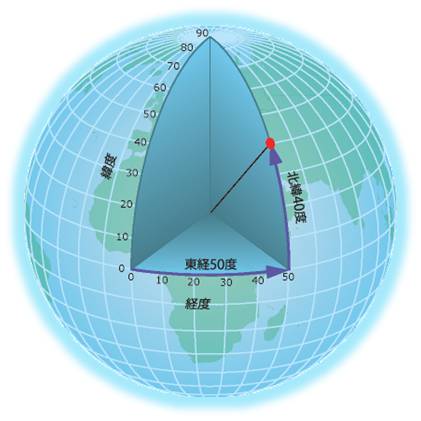

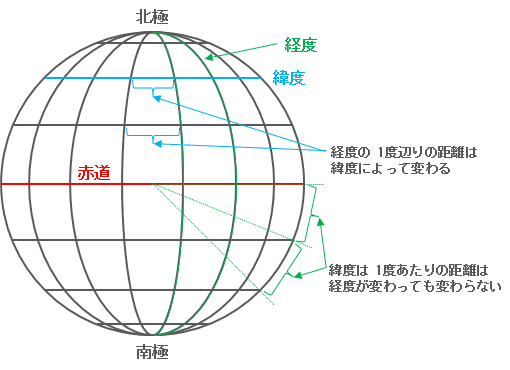

測地系とは、ジオイドにどのような楕円体を当てはめるかの体系を示しているものです。下の図にように、ある特定の地域によく適合する楕円体を定義することもできますし、あらゆる地域にまずまずの精度でフィットするような楕円体を定義することもできます。前者をローカル測地系、後者を世界測地系と呼びます。両者の大きな違いは楕円体の原点の位置です。世界測地系では、楕円体の原点が地球の重心と一致する地心直行座標系が適用されています(下の左図と右図で大きく原点の位置がずれていることが見て取れます)。上の図からも分かるように、地理座標系では直交座標系のような二次元空間で場所を定義するのではなく、北から南までの尺度となる緯度(北極点を90°N、南極点を90°S、赤道を0°としたもの)で表し、その点の集合である緯線は北から南まで平行に走っていることが分かります。東から西までの尺度として経度(東に180°、西に180°、本初子午線を0°とした)となり、その点の集合が経線になります。経線は緯線と異なり平行に走らず、経線間の距離は高緯度方向に近づくほど短くなります(下図参照)。具体的には赤道での距離は111kmですが、極付近ではゼロへと近づくことになります。

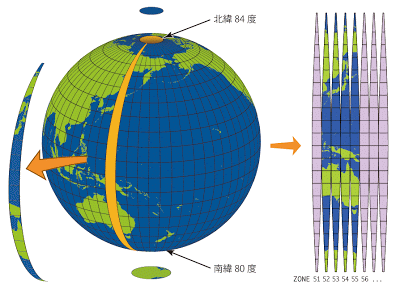

地理座標系では地球を理想的な楕円体に合わせて作成されているため、ある地点の地理情報(距離、方位、面積)を正確にとらえていると言えます。しかし、地理座標系を用いて地点間の距離、方位、そして面積求めるためには複雑な計算を必要とするため、一般的に用いられるには不向きです。この三次元の情報を二次元に置き換える(投影)ために、平面座標系が発展しました。平面座標系では直交座標系と同じく地点の情報はX軸(東から西)とY軸(北から南)で表されます。 平面座標系で特に有名なものとして、UTM(Universal Transverse Mercator)があります。このTransverse Mercator(横メルカトル)とは、地理座標を地球楕円体から平面座標へと置き換えるための手法のことです。

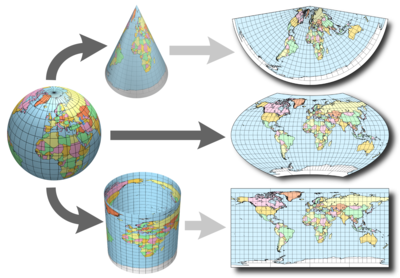

UTM座標系では地球を60分割にし、それを繋ぎ合わせたものと考えると分かりやすいです。この一つ一つをゾーン(zone)と呼び、一つのゾーンは緯度6度分の間隔になっています。このゾーンは中央で膨らみ高緯度で狭くなります(上図参照)。 地理座標系と異なり、UTM座標系は各々のゾーンは赤道を中心に北と南で半分に分け、原点は北と南どちらにも与えられ、XY座標が各々の原点から定義されます。つまり、UTMである地点を定めるには、ゾーン、南か北か、X座標、Y座標と4つのパラメーターを知る必要があるということです。 地図投影法 地理座標系を二次元平面に変換するときに用いられるのが地図投影法になります。 地理座標系の要素を再確認しましょう: 角度(Angular):地球を回転楕円体として捉えた時、対象物の位置を図るための座標の単位。 回転楕円体(Spheroid):どの回転楕円体(地球楕円体)を利用するか。 原点、データム(Datum):設定した回転楕円体において、ある対象物の位置がどこになるのかを定めるための幾何学的な基準。 本初子午線(Prime meridian):設定した測地系において、経線の基準になるもの 地理座標系では三次元の地球を数値化して対象物の位置を示されていました。地図投影法ではこの三次元の情報を二次元に変換しますが、その手法には大きく3つの投影方法があります。

- 円錐図法(Conic projection):地球に円錐に対して投影し、平面に広げたもの

- 方位(幾何)図法(Azimuthal projection):回転楕円体のグリッドが平面に投影される

- 円筒図法(Cylindrical projection):地球を円筒形で包み込み、それに投影して平面に広げたもの

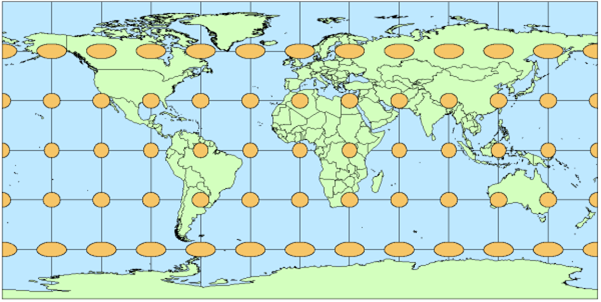

地理座標系では全ての地域を一定の尺度で管理可能で、複雑な計算を要するが対象物の地球表面上での位置を正確に表すことが可能になります。一方で、地理座標系の座標を平面上に投影した場合、距離、面積、角度には歪みが生じます。下図では地球球面上に描いた同じ大きさの円を二次元平面に投影しています。円の形状は場所によって歪み、正確に表現できないことがわかります。

図の中心から外れるほど、円の形が歪むことがわかります

出典:https://www.esrij.com/gis-guide/coordinate-and-spatial/coordinate-system/

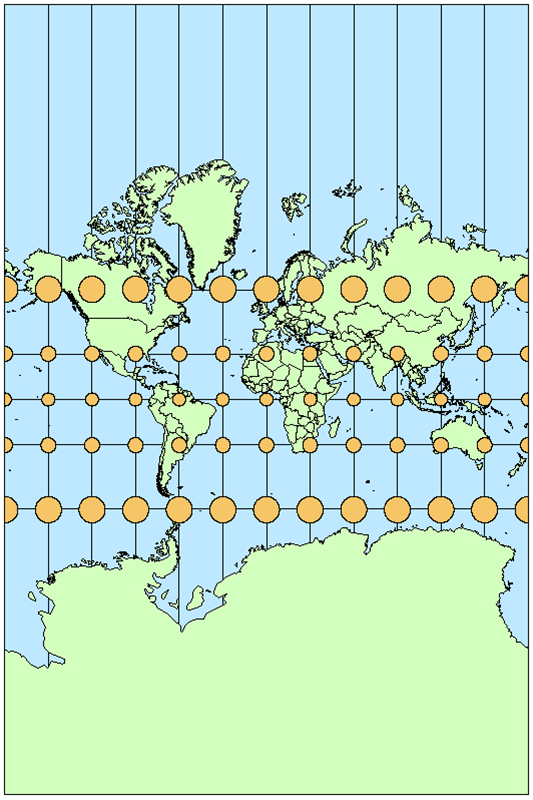

地理座標系では全ての地域を一定の尺度で管理可能で、複雑な計算を要するが対象物の地球表面上での位置を正確に表すことが可能になります。一方で、地理座標系の座標を平面上に投影した場合、距離、面積、角度には歪みが生じます。下図では地球球面上に描いた同じ大きさの円を二次元平面に投影しています。円の形状は場所によって歪み、正確に表現できないことがわかります。 どの投影手法を用いても幾何的な歪みを抑えることはできませんが、使用する投影法によって一部の幾何的な性質を維持することができます(目的に応じて、どの性質を保存するのか選ぶとも言えます)。下図では正角図法の一つであるメルカトル図法を用いて投影しています。どの地点でも円は歪むことなく描写され、地球表面の角度が正しく表現できていることを示しています(他方で面積には歪みが生じます)。何を正確に示したいのかによって、使用する投影法を選択する必要があることがわかるかと思います。

測地系

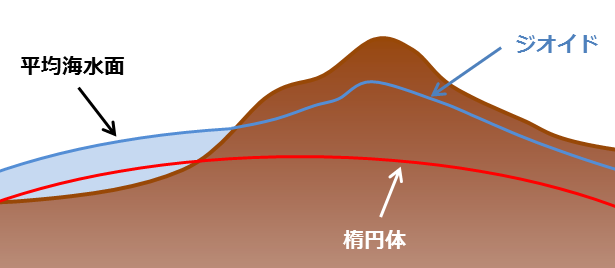

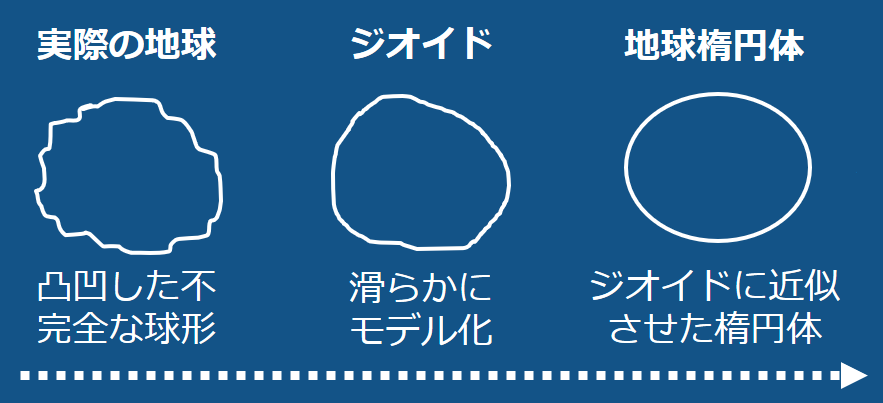

最後に測地系の説明をしましょう。地球上での位置情報を平面に変換するためには投影法を用いる必要がありましたが、そもそも地球をどうやって理想的な楕円体として捉えているのでしょうか。下の図で示すように地球の表面は起伏に富んでいますので、このままでは位置情報を正確に定義することはできません。

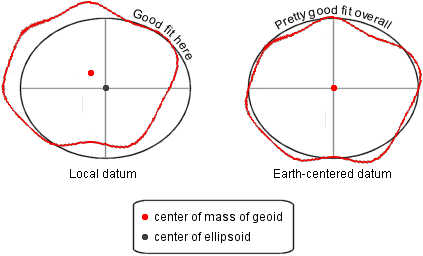

測地系とは、ジオイドにどのような楕円体を当てはめるかの体系を示しているものです。下の図にように、ある特定の地域によく適合する楕円体を定義することもできますし、あらゆる地域にまずまずの精度でフィットするような楕円体を定義することもできます。前者をローカル測地系、後者を世界測地系と呼びます。両者の大きな違いは楕円体の原点の位置です。世界測地系では、楕円体の原点が地球の重心と一致する地心直行座標系が適用されています(下の左図と右図で大きく原点の位置がずれていることが見て取れます)。

このように様々な方法を利用して「楕円な」地球の地理情報を平面に置き換えていることがわかるかと思います。衛星画像を地図上の適切な位置に描写するためには、その地図が投影されたのと全く同じ方法で衛星画像を平面上に配置する必要があります。GISアプリケーションでは、これらの情報を座標参照系(CRS:Coodinates Reference System)として操作することが可能です。重要なことは、地球を理想的な楕円体と考えるために使用した測地系と、地理座標系の情報を平面上に変換するために利用した投影方法を把握することです。

8. 地図タイル

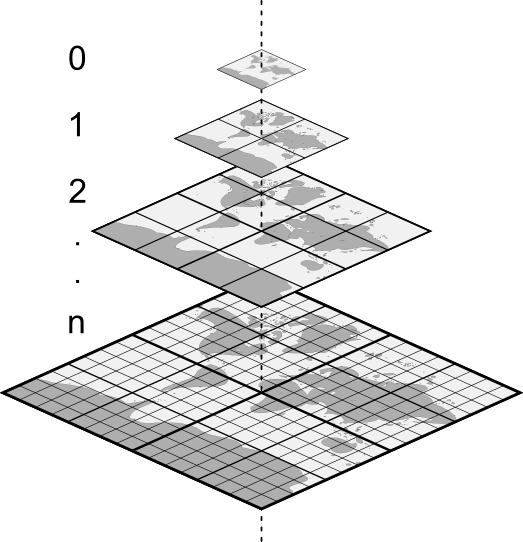

Tellusで配信されているデータもそうですが、衛星画像はWeb上でタイル状の画像として用いられることがあります。このようなタイルの集まりで構成された地図は、Web上で衛星画像を効率よく描写するためのシステムであるタイル座標系で定義されています。

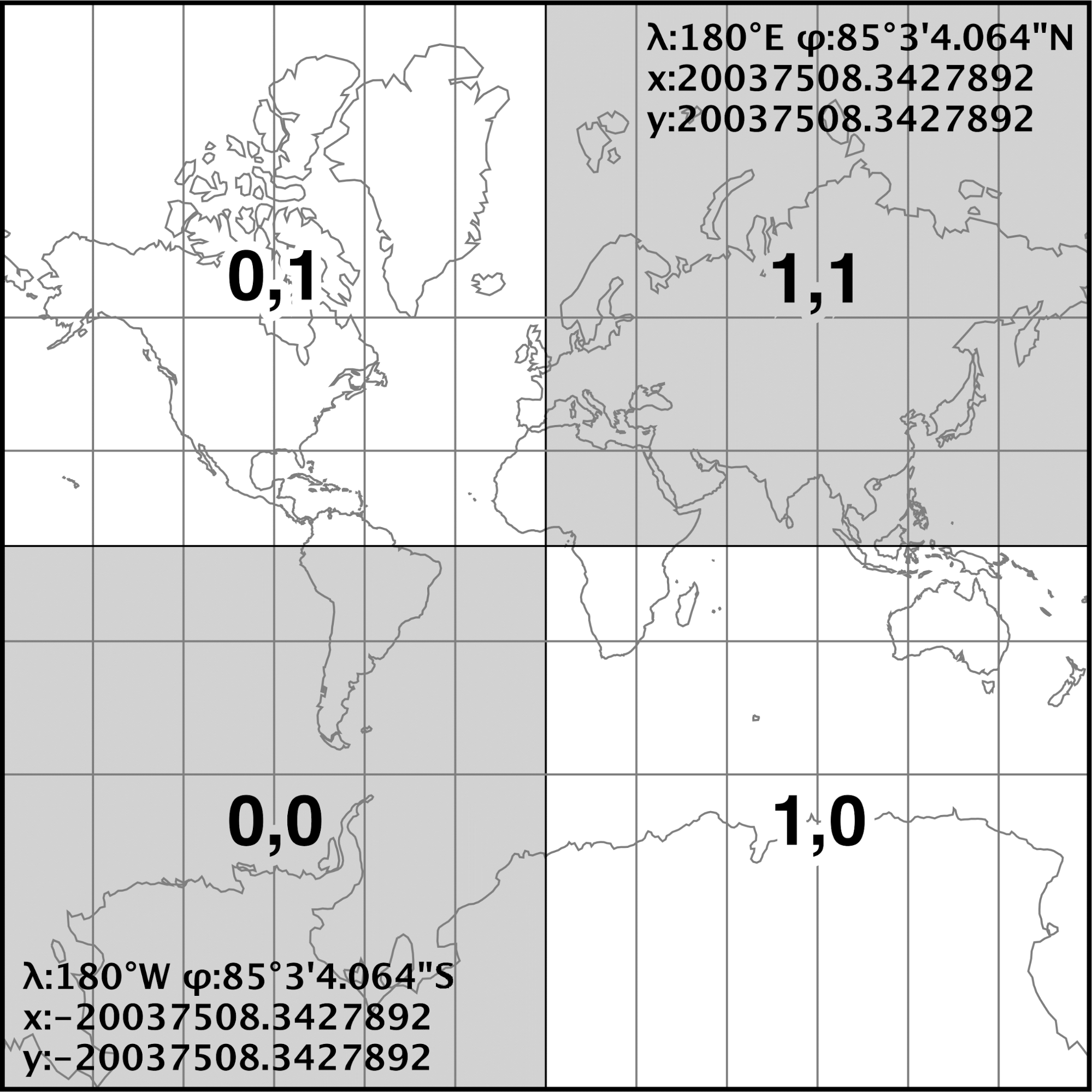

タイル座標系では画面の左上または左下が原点になり、画面右方向へX軸、画面上方向へY軸があります。

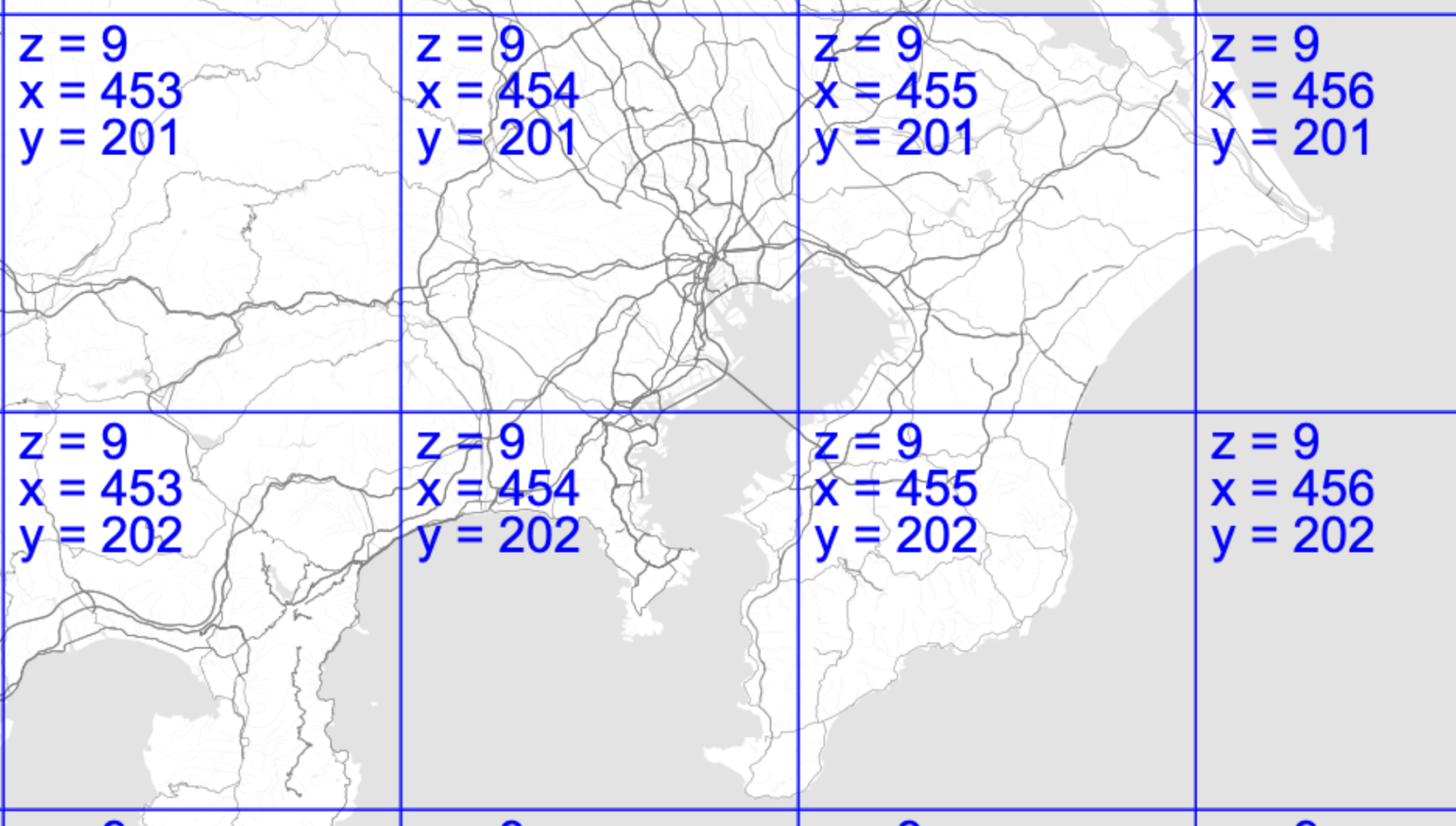

上の図で示されているように、平面上のタイルの数はズームレベルに応じて増加します(2^(zoom×2))。地球全体を投影した256×256の正方形で表したものをズームレベルが0と定義し、ズームレベル1では、その平面が4つに分割されていることがわかります(各々のタイルサイズは256×256のままです)。各々のタイルにはXY軸からなるタイル座標が定義されており、西経180度、南緯約85.34064度の南西端を端点にもつタイルを(X,Y)=(0,0)として東方向をX正方向、北方向をY正方向にとります。Open Street Map(OMS)ではタイルの(0,0)は北西にあり、東にX軸が伸びることは変わりませんが、南方向へY正方向をとります。

図はTellus OS上で地図タイルを示したもの。TellusではOMSを使用しているため、地図タイルもOMSに従っている。X正方向は東、Y正方向は南であることがわかります。

参考文献

- Characteristics of Images | Natural Resources Canada

- How to Convert a Picture to Numbers

- Know Basics of Remote Sensing Quickly and Become Expert

- Why is that Forest Red and that Cloud Blue? How to Interpret a False-Color Satellite Image

- 光の波長って何? なぜ人工衛星は人間の目に見えないものが見えるのか

- 気象衛星センター | 近赤外画像の特徴

- Exploring the middle infrared region for urban remote sensing: seasonal and view angle effects

- https://www.cambridge.org/core/journals/journal-of-glaciology/article/applications-of-satellite-thermal-infrared-images-for-monitoring-north-water-during-the-periods-of-polar-darkness/883E067C02921D1B68855F08B616D5A5/core-reader

- A Review: Remote Sensing Sensors

- もっと知りたい! 熱流体解析の基礎37 第4章 伝熱:4.6.3 反射・吸収・透過

- Q&A

- Electromagnetic Radiation | Natural Resources Canada

- https://www.esrij.com/gis-guide/coordinate-and-spatial/coordinate-system/

- https://www.earthdatascience.org/courses/earth-analytics/spatial-data-r/intro-to-coordinate-reference-systems/

- 政春尋志(2011). 地図投影法

- https://www.e-education.psu.edu/geog260/node/1912